CCE GPU Manager 说明

更新时间:2025-08-05

组件介绍

一系列 GPU device plugin 的集合,结合配套的 scheduler 可以实现复杂场景下的 GPU 资源调度能力。CCE GPU Manager组件支持隔离最优型,可支持算力和显存的共享与隔离。

组件功能

- 拓扑分配:提供基于 GPU 拓扑分配功能,当用户分配超过1张 GPU 卡给 Pod 时,系统自动选择拓扑连接最快的方式分配 GPU 设备。

- GPU 共享:提供为节点上的 GPU 设备开启显存共享功能,支持将 GPU 卡按显存大小分配给多个 Pod。

- 显存和算力隔离:多 Pod 共享单张 GPU 卡时进行显存和算力级别的隔离。

- 精细化调度:开启精细化调度后,创建队列和任务时均支持选择具体的GPU型号。关闭精细化调度后创建队列和容器时仅支持输入配额,不支持选择具体的GPU型号。

- 编解码实例:提交编解码任务,使用GPU独立的编解码单元进行硬件编/解码。

- 组件详细使用说明请参照:GPU独占和共享说明

使用场景

在 CCE 集群中运行 GPU 应用时,可以解决 AI 训练等场景中独占整张卡造成资源浪费的情况,从而提高资源的使用率,降低成本。

限制说明

- 支持 v1.18 及以上版本的 Kubernetes 集群。

- 目前该组件依赖于 CCE AI Job Scheduler,若您需要请一同安装,否则可能导致组件功能不可用。

- GPU 共享虚拟化目前适配了以下主流的GPU CUDA和Driver版本,其中隔离最优型对操作系统内核版本等有额外的要求。如您有其他版本适配需求请提交工单。目前支持情况具体如下。

| 配置 | 版本 |

|---|---|

| 容器运行时 | Docker、Containerd |

| GPU CUDA/Driver版本 | |

| 操作系统内核版本(仅隔离最优型) | CentOS: Ubuntu: |

安装组件

- 登录百度智能云官网,并进入管理控制台。

- 选择“产品服务 > 云原生 > 容器引擎 CCE”,单击进入容器引擎管理控制台。

- 单击左侧导航栏中的 集群管理 > 集群列表 。

- 在集群列表页面中,单击目标集群名称进入集群管理页面。

- 在集群管理页面单击 运维与管理 > 组件管理 。

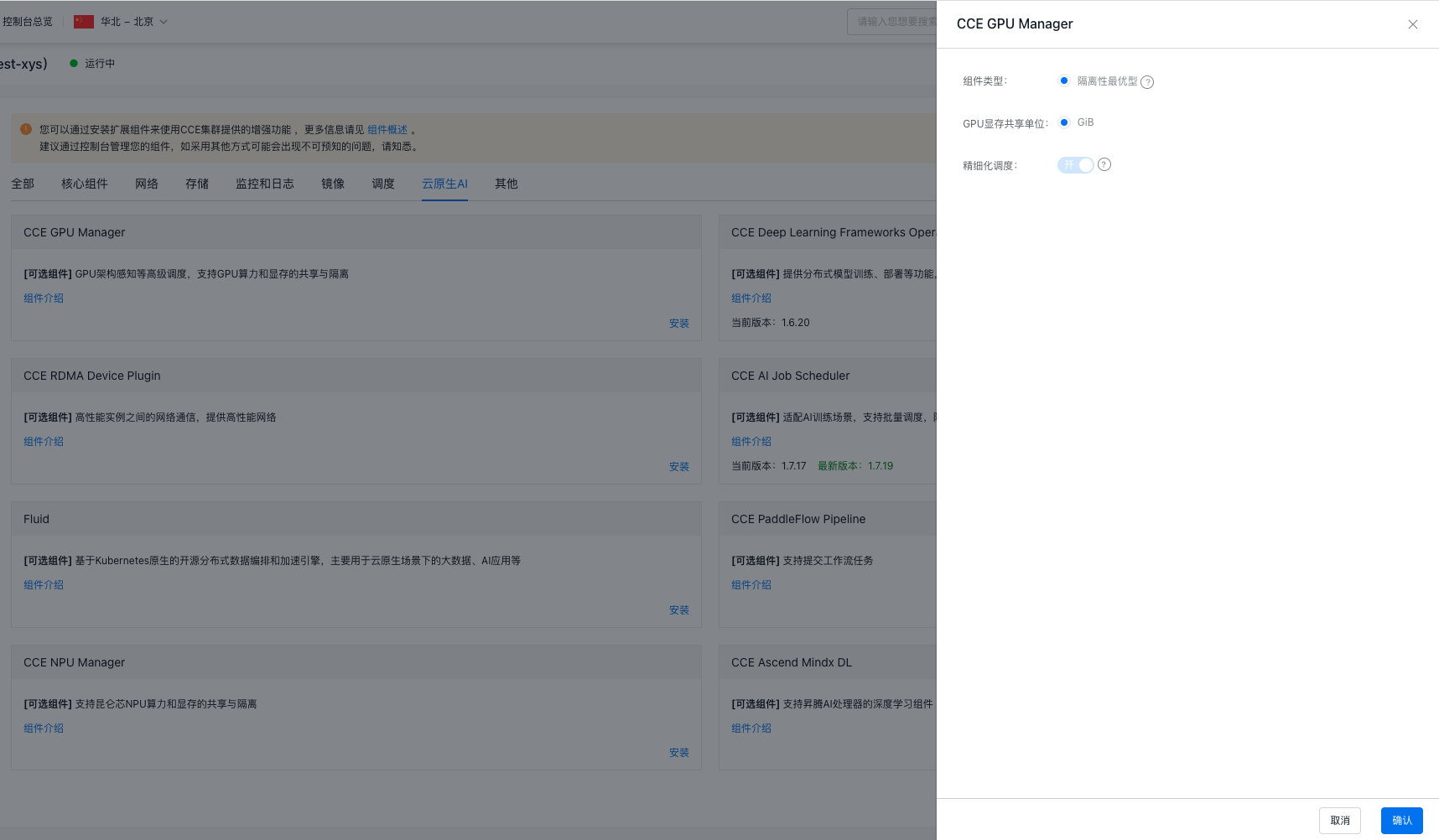

- 在组件管理列表中选择 CCE GPU Manager 组件单击"安装"。

- 在确认安装弹出框中默认选择隔离最优型。

- GPU显存共享单位默认选择GiB。

- 精细化调度默认开启。

- 点击“确认”按钮完成组件的安装。

版本记录

| 版本号 | 适配集群版本 | 更新时间 | 变更内容 | 影响 |

|---|---|---|---|---|

| 1.5.48 | CCE v1.18+ | 2025.05.13 | 优化: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.47 | CCE v1.18+ | 2025.04.14 | 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.45 | CCE v1.18+ | 2025.03.21 | 新功能: 优化: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.44 | CCE v1.18+ | 2025.03.11 | 新功能: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.42 | CCE v1.18+ | 2025.02.12 | 新功能: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.41 | CCE v1.18+ | 2025.01.24 | 新功能: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.40 | CCE v1.18+ | 2024.12.31 | 新功能: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.39 | CCE v1.18+ | 2024.11.07 | 新功能: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.38 | CCE v1.18+ | 2024.10.18 | 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.37 | CCE v1.18+ | 2024.09.10 | 新功能: 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.36 | CCE v1.18+ | 2024.08.05 | 新功能: 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.35 | CCE v1.18+ | 2024.07.05 | 新功能: 优化: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.34 | CCE v1.18+ | 2024.06.24 | 优化: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.33 | CCE v1.18+ | 2024.05.31 | 新功能: 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.32 | CCE v1.18+ | 2024.05.15 | 新功能: 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.31 | CCE v1.18+ | 2024.05.06 | 新功能: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.30 | CCE v1.18+ | 2024.03.26 | 新功能: 修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.29 | CCE v1.18+ | 2024.01.19 | 新功能: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.28 | CCE v1.18+ | 2023.12.15 | 新功能: 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.27 | CCE v1.18+ | 2023.12.1 | 优化: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.26 | CCE v1.18+ | 2023.11.17 | 新功能: 优化: 缺陷修复: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.25 | CCE v1.18+ | 2023.11.03 | 新功能: 优化: 增加对节点的 sgpu.ko 内核前置检查:增加残留模块版本校验以及残留无效模块删除重装 缺陷修复: 限制: |

GPU内核态虚拟化业务不支持热升级,升级方式为排空节点升级 |

| 1.5.24 | CCE v1.18+ | 2023.09.22 | 新功能: 缺陷修复: 使用限制: |

|

| 1.5.23 | CCE v1.18+ | 2023.08.29 | 优化: 使用限制: |

|

| 1.5.22 | CCE v1.18+ | 2023.08.10 | 缺陷修复: 使用限制: |