如何发布自然语言处理任务API

更新时间:2023-01-18

模型仓库中的NLP模型,发布为公有云部署时运行在云端,可通过独立Rest API调用模型,实现AI能力与业务系统或硬件设备整合。

BML具有完善的鉴权、流控等安全机制,并配置丰富的资源集群稳定承载高并发请求。

并且支持查找云端模型识别错误的数据,纠正结果并将其加入模型迭代的训练集,不断优化模型效果

公有云部署

模型部署流程

- 将训练完成的模型发布到模型仓库,在模型仓库中的『版本列表』中点击『公有云部署』或者点击左侧导航栏的公有云部署,进入公有云部署界面后点击『部署模型』。

- 在部署界面,首先进行服务配置:自定义服务名称、接口地址后缀,选择需要部署的模型,

- 对每个部署模型还需要进行资源配置,配置模型预测服务所需机器资源。目前资源开放CPU类型,支持按配额与实例进行灵活配置,计费说明请点击查看

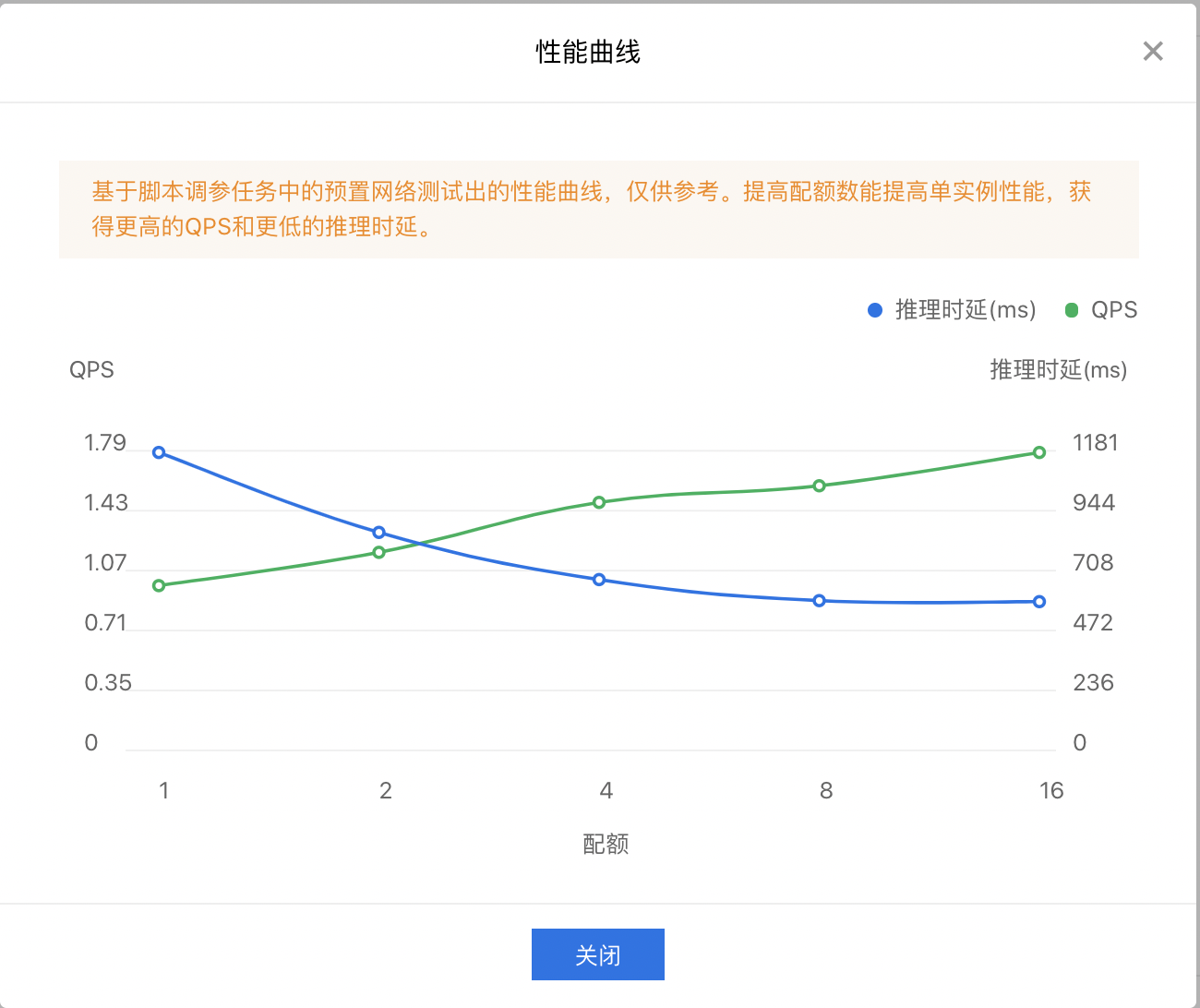

- 当部署模型为脚本调参任务产出的模型时,系统会自动显示该模型在当前配置下的预估时延和QPS。点击"性能曲线",即可查看单实例下的推理时延,QPS与配额的曲线关系,您可以根据性能曲线配置合理的配额。

-

配置完成后,点击开始部署即可一键部署模型,并获得专用的API地址。

说明:

1、系统将运行公有云部署的机器资源1核cpu和4G内存折算为1配额,提高配额数量能提升QPS和降低推理时延

2、实例为cpu资源运行的实例数,为保证服务的稳定性,实例数至少需要配置为2。实例数与QPS成正比关系,提高实例数时,QPS能正比增加

接口赋权

- 正式使用还需要对接口进行赋权,在已发布的服务的详情界面,点击『控制台』进入BML控制台。

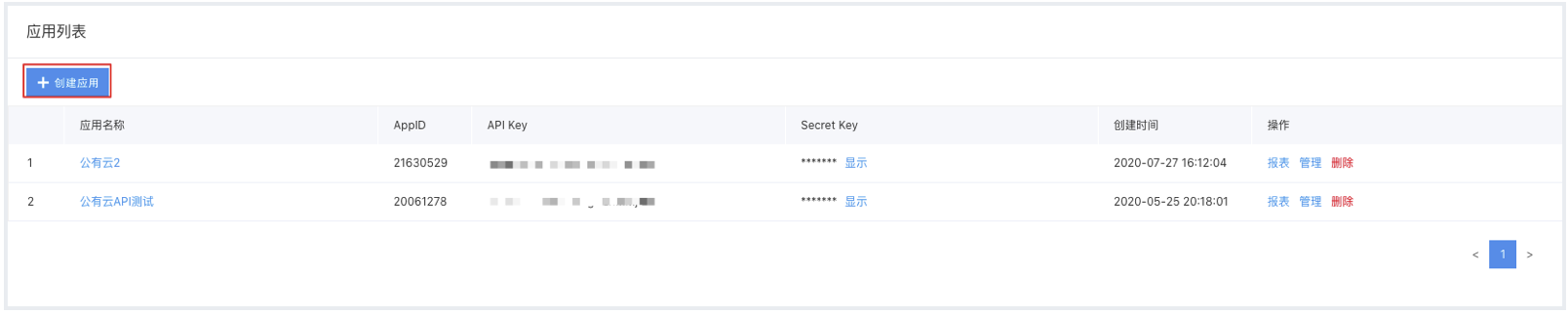

- 在控制台中创建一个应用,获得由一串数字组成的appid,然后就可以参考接口文档正式使用了

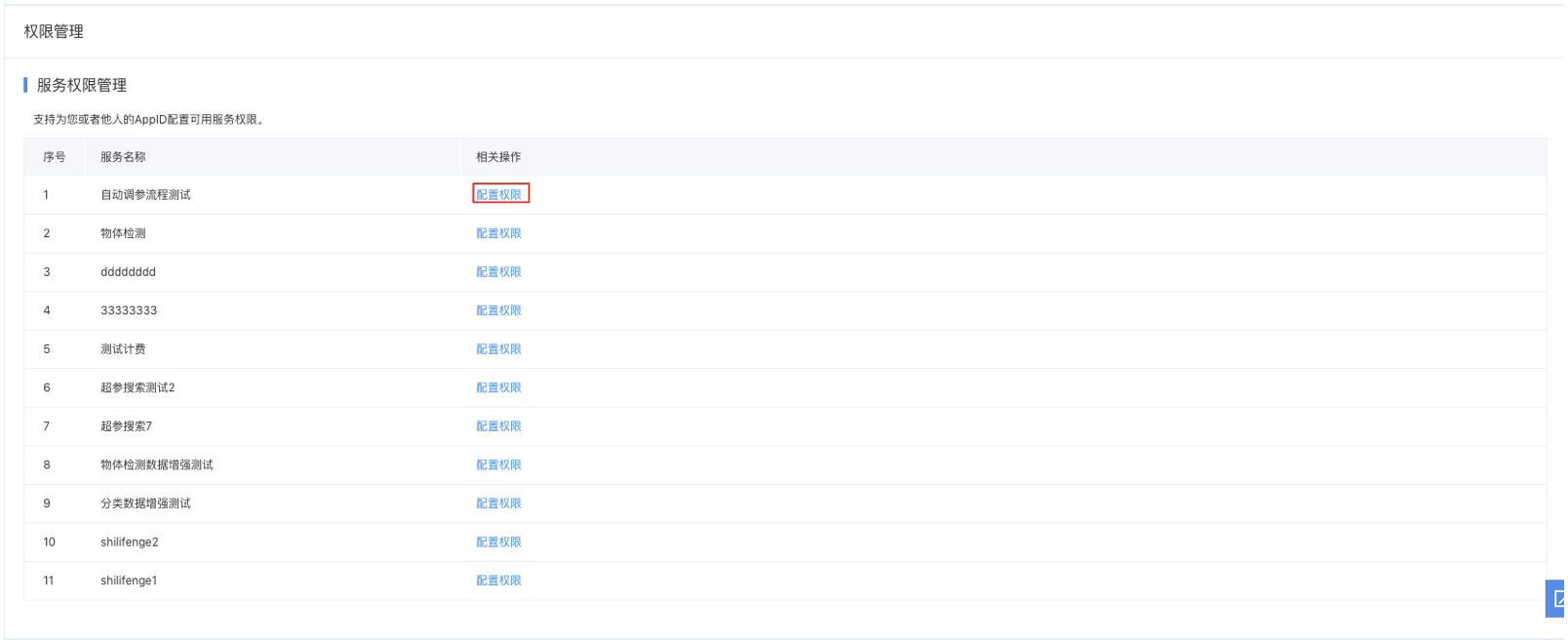

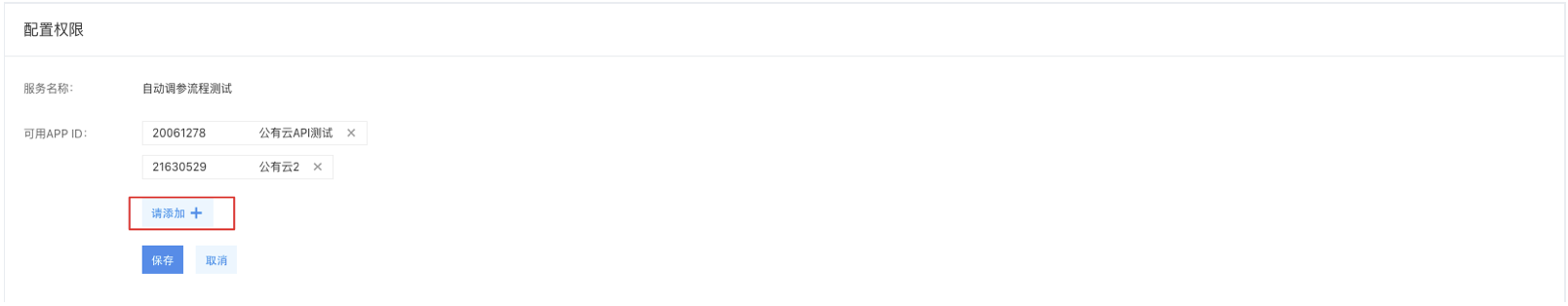

- 如需为第三方用户配置调用接口的权限,可以前往BML控制台-公有云服务管理-权限管理配置

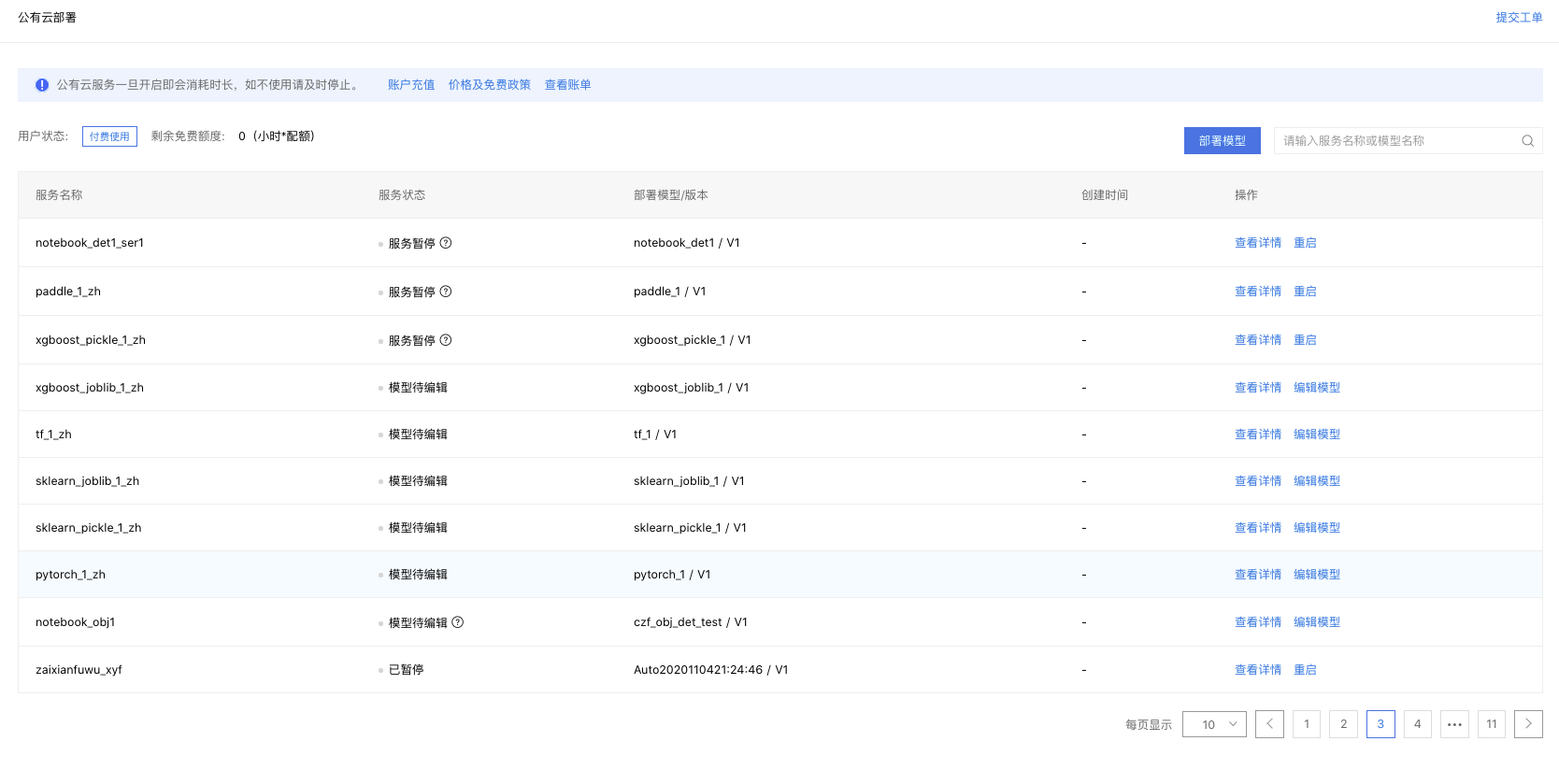

公有云部署列表

公有云部署列表信息由历史提交公有云服务组成,显示服务的基本信息。

如图,在预测服务列表页支持以下操作:

查看详情:点击进入该公有云服务的详情界面

重启:对已停止或部署失败的服务进行重新创建,恢复对应的服务为可用状态

停止:停止该公有云服务,用户不再使用相关服务后可进行这一操作,停止后将不进行计费

编辑模型:对于已经部署为公有云服务,但尚未配置机器资源的模型,点击可以配置机器资源