使用Ollama部署大语言模型

更新时间:2025-11-24

Ollama是一个开源的大模型管理工具,它提供了丰富的功能,包括模型的训练、部署、监控等。 您可以通过Ollama轻松地管理本地的大模型,提高模型的训练速度和部署效率。 百舸工具市场预置了Ollama镜像模板,您可以使用模板快速搭建Ollama工具,使用Ollama进行大语言模型推理

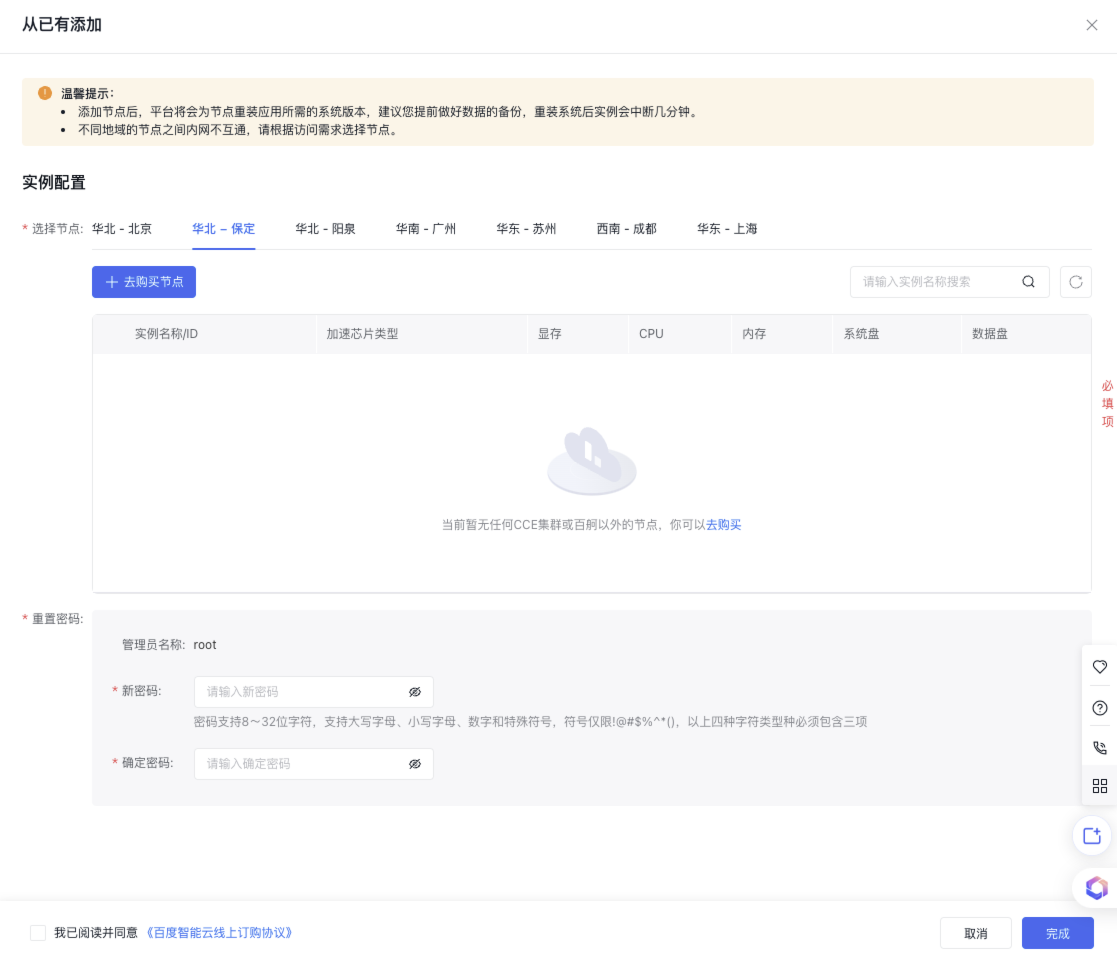

准备环境和资源

可根据资源规模、稳定性、灵活性等要求按需准备轻量计算实例或通用计算资源池,用于快速部署Ollama。

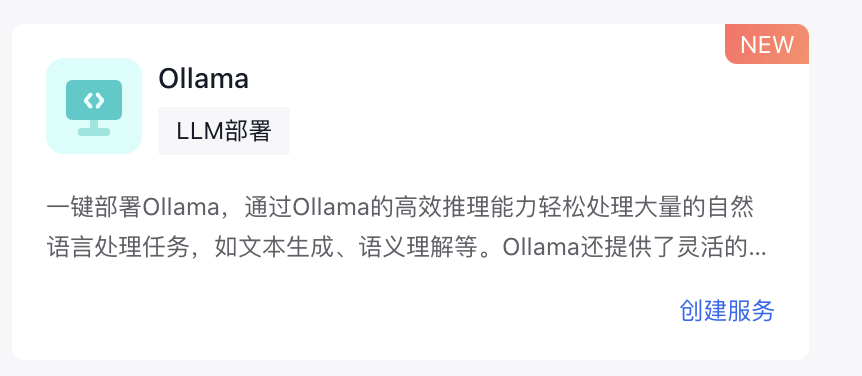

安装 Ollama

在百舸平台的工具市场中选择Ollama模版,点击 部署工具 按钮;根据需要部署的模型参数量,选择使用卡数量,至少需要选择1张卡,点击 确定 等待工具启动。

部署模型

您可以在官方模型仓库https://ollama.com/library 找到您想部署的模型,通过JuypterLab部署模型。 除了官方模型仓库提供的模型,您也可以直接加载下载到本地的模型文件。模型文件存储到 OLLAMA_MODELS=/root/ollama/ollama_cache/models 路径。

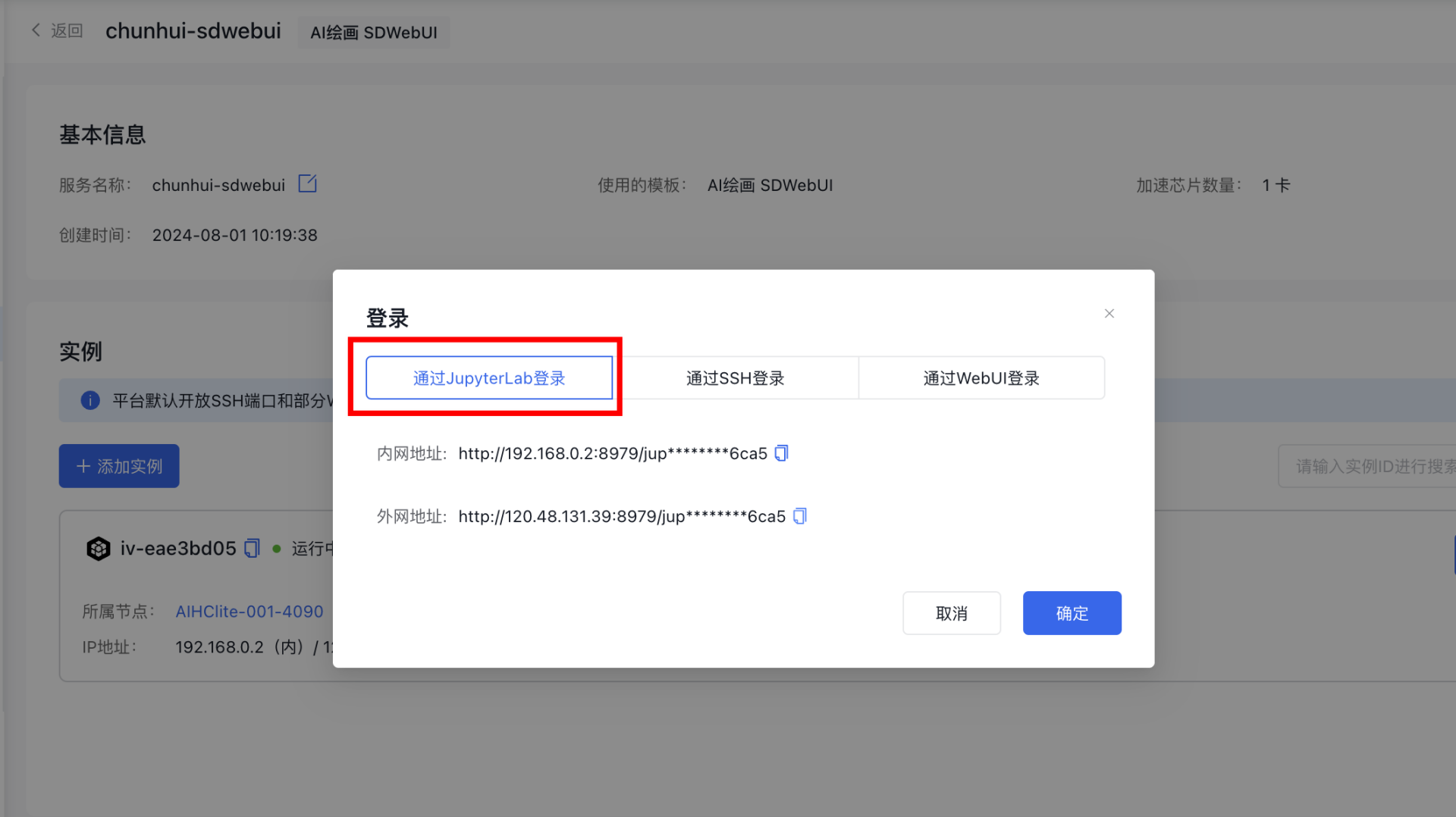

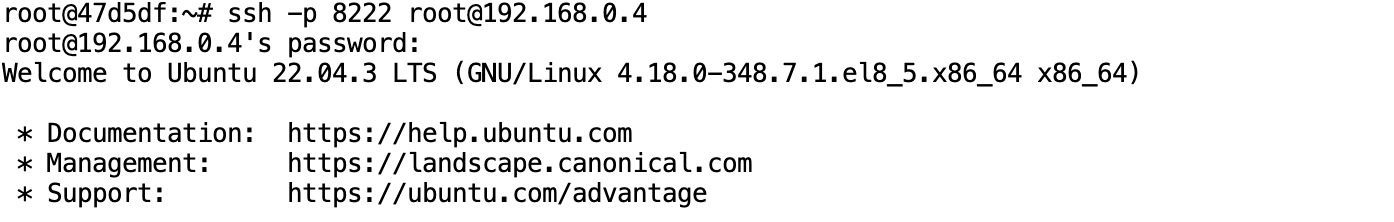

- 通过JupyterLab登录

在工具详情中,点击 登录 查看JupyterLab访问地址和SSH登录信息,

您可以在浏览器中打开JupyterLab或使用其他工具通过SSH登录

- 启动Ollama服务

启动服务

Plain Text

1#启动ollama服务

2ollama serve- 下载模型

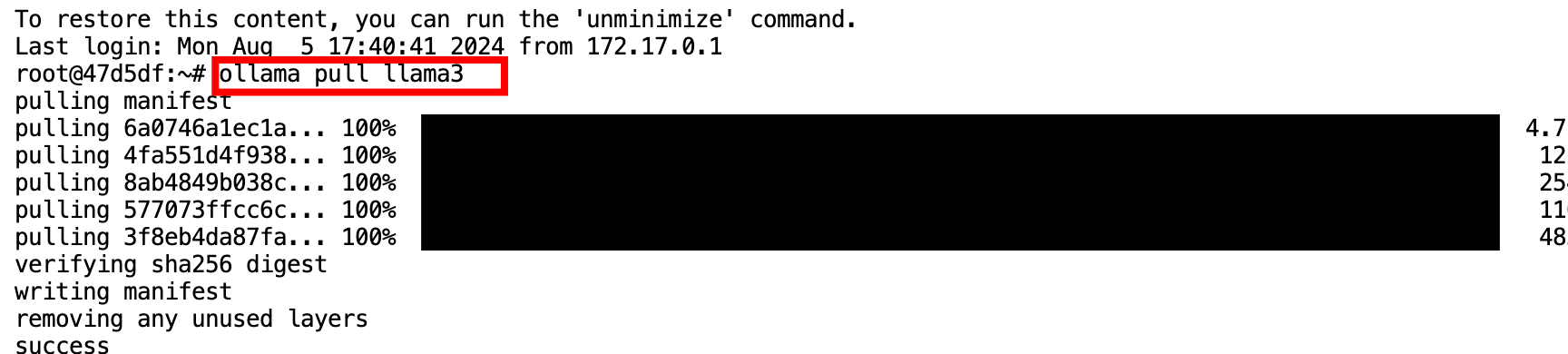

以部署Llama3 模型为例,使用此命令下载模型

Plain Text

1ollama pull llama3下载成功示例:

- 其他命令

Plain Text

1#启动ollama服务

2ollama serve

3#从模型文件创建模型

4ollama create

5#显示模型信息

6ollama show

7#运行模型

8ollama run 模型名称

9#从注册表中拉去模型

10ollama pull 模型名称

11#将模型推送到注册表

12ollama push

13#列出模型

14ollama list

15#复制模型

16ollama cp

17#删除模型

18ollama rm 模型名称

19#获取有关ollama任何命令的帮助信息

20ollama help模型测试验证

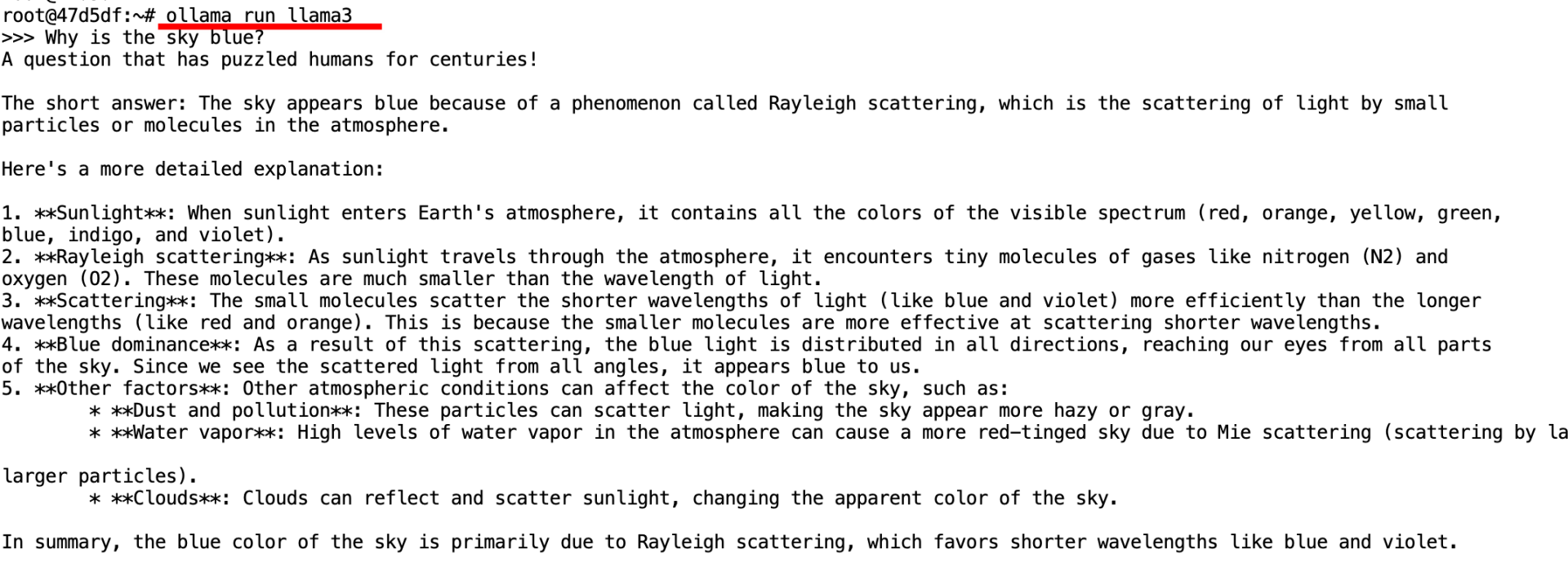

命令行测试模型

使用此命令启动模型,进行在线测试。

Plain Text

1ollama run llama3

通过API调用模型

- 获取OpenAPI 地址

单击 登录,查看OpenAPI地址

- 调用API

使用以下代码通过API调用模型。

Plain Text

1#Generate a response

2curl http://106.12.158.93:8028/api/generate -d '{

3 "model": "llama3",

4 "prompt":"Why is the sky blue?",

5 "stream": false

6}'

Plain Text

1#Chat with a model

2curl http://106.12.158.93:8028/api/chat -d '{

3 "model": "llama3",

4 "messages": [

5 { "role": "user", "content": "why is the sky blue?" }

6 ],

7 "stream": false

8}'更多API信息可以查看Ollama官方文档 https://github.com/ollama/ollama/blob/main/docs/api.md