开发作业

更新时间:2025-01-23

注:自2024年6月30日起,MapReduce暂不提供作业相关功能支持,可通过第三方平台EasyDAP或开源组件Airflow提交任务。

使用hadoop镜像的集群可添加的作业类型是:java,streaming。使用spark镜像的集群可添加作业类型:spark,java,streaming。集群中添加了应用后便可添加该应用的作业,即创建集群时添加了hive应用,则可创建hive作业,添加了pig应用,则可创建pig作业。

创建作业的操作步骤如下:

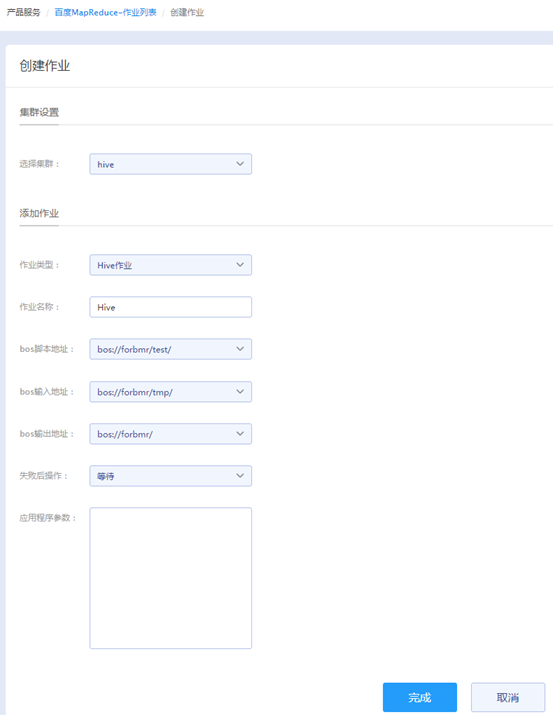

- 在“产品服务>MapReduce>MapReduce-作业列表”页中,点击“创建作业”,进入创建作业页。

-

请在创建作业页选择作业类型并配置作业类型对应的参数。以下列举了Hive作业类型对应参数配置说明:

Hive作业:

- 作业名称:输入作业名称,长度不可超过255个字符。

- bos脚本地址:BOS的脚本地址必须是一个有效的BOS路径,并且指向Hive脚本。

- bos输入地址:这个地址必须已经存在,并且您有权限读取这个地址的文件。可在脚本中通过${INPUT}引用这个地址。

- bos输出地址:写入的bucket之后的地址必须是不存在的,但您有权限对这个地址进行写操作,否则作业运行会失败。可在脚本中通过${OUTPUT}引用这个地址。

- 失败后操作:选择作业运行失败后的操作:继续(作业执行失败后,继续执行下一个作业)和等待(作业执行失败后,查看作业运行的状态,并且取消后续作业)。

- 应用程序参数:只接受两种参数类型,分别是--hiveconf key=value 和 --hivevar key=value。前一种参数是用来覆盖hive执行时的配置。后一种参数是用来声明自定义的变量,可以在脚本中通过${KEY}来引用。输入参数时,只需要输入参数本身字符串即可,用空格分隔,无需参数转义和url encode。

- 选择适配的集群。

-

点击“完成”,则作业创建完成。

- 当作业状态会由“等待中”更新为“运行中”状态,作业运行完毕后状态更新为“已完成”。

- (可选)只有等待中或运行中的作业可被取消,点击“取消作业”即可。