HuggingFace模型下载、部署、调用实战

更新时间:2025-10-30

1. 模型下载

从HuggingFace获取模型

参考文档:将HuggingFace模型下载到BOS

示例模型:Qwen2.5-0.5B-Instruct

注意:请确保您有该模型的使用权限并遵守相关许可协议

2. 模型创建

操作路径

导航至:"模型管理" → "我的模型" → "创建模型"

关键配置参数

| 配置项 | 推荐值 | 说明 |

|---|---|---|

| 模型类型 | 文本生成 | 根据模型实际功能选择 |

| 模型来源 | 对象存储BOS | 选择已上传模型的存储位置 |

| Bucket | your-bucket-name | 替换为您实际的Bucket名称 |

| 文件夹路径 | Qwen/Qwen2.5-0.5B-Instruct | 指向模型文件所在目录 |

| 模型格式 | HuggingFace | 确保与下载的模型格式一致 |

| 输入输出模式 | 对话 | 适用于对话型模型 |

| 基础模型版本 | 其他 | 自定义模型选择此项 |

| 推理引擎及版本 | vLLM (>0.8.3) | 推荐使用vLLM高性能推理引擎 |

| 高级配置 | 默认值即可 | 系统推荐启动命令 |

3. 服务部署

创建服务

导航至:"模型服务" → "我的服务" → "创建服务"

重要参数说明:

-

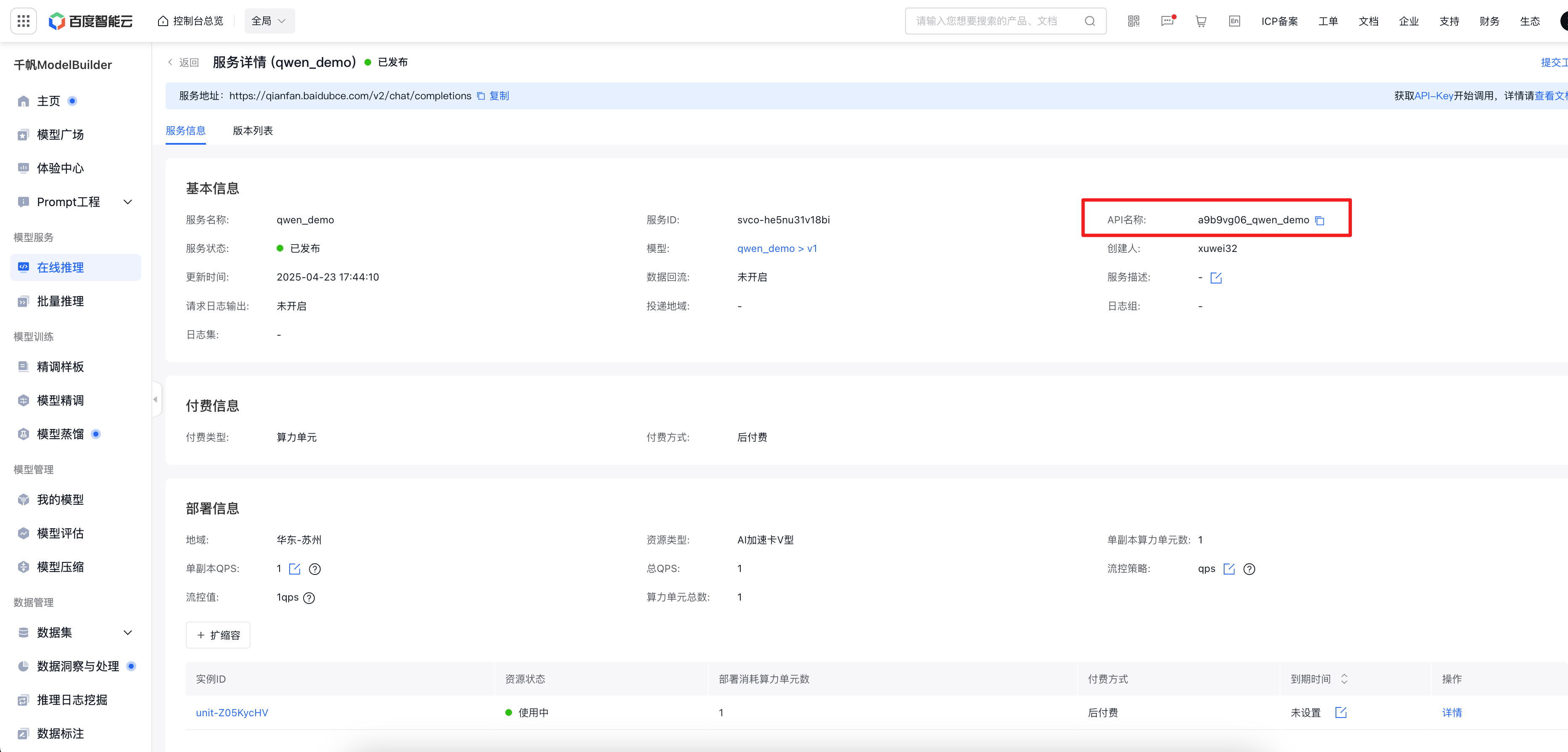

API地址:自动生成8位随机码_自定义后缀格式(如a9b9vg06_qwen_demo)- 该地址将作为API调用的

model参数

- 该地址将作为API调用的

部署流程

- 选择目标模型

- 配置计算资源(根据模型大小选择合适规格)

- 启动部署

部署完成验证

4. 模型测试

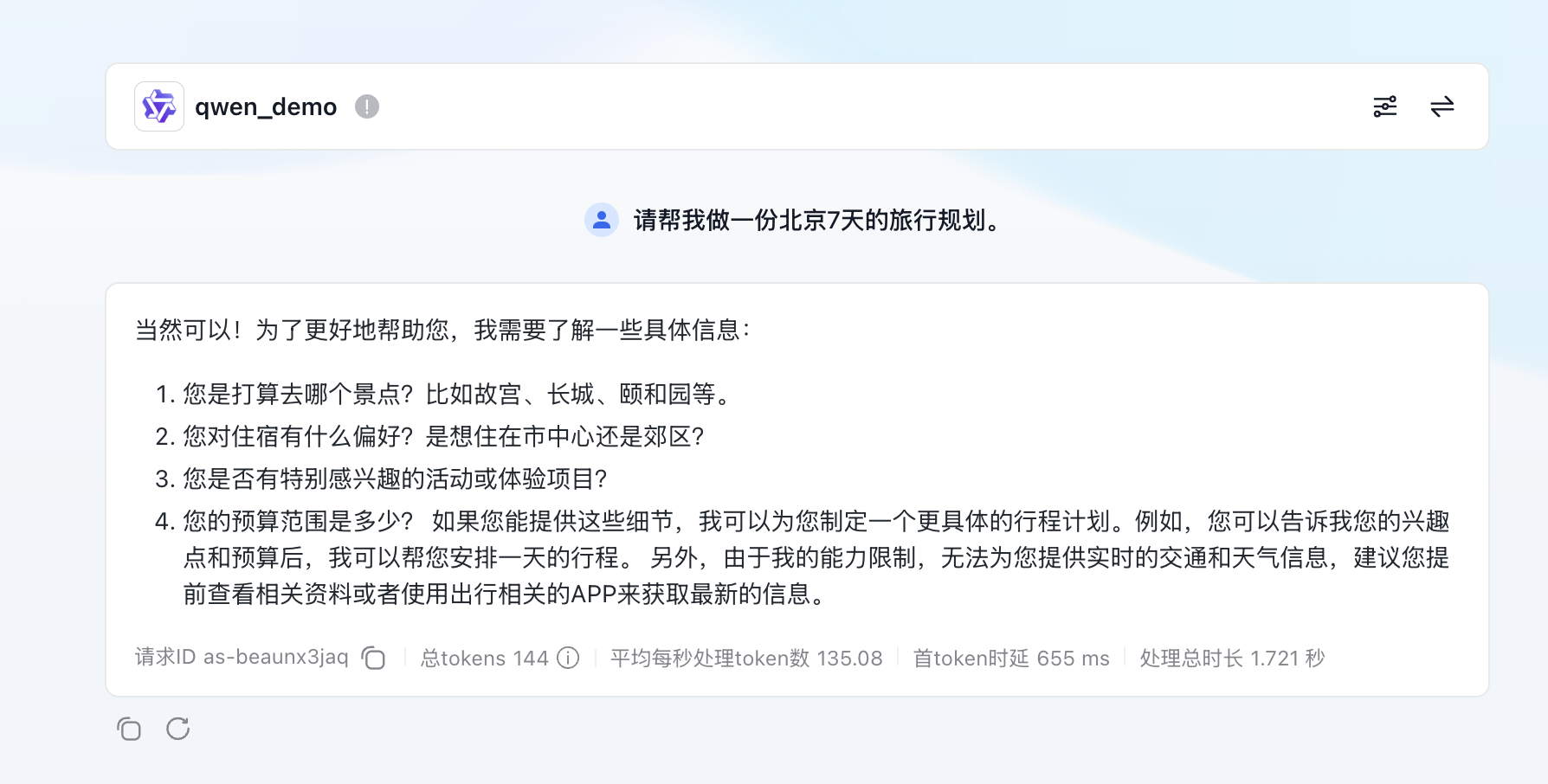

4.1 控制台体验

- 访问体验中心

- 选择已部署的模型(如

qwen_demo) - 输入测试Prompt进行验证

4.2 API调用

参考:文本生成API文档

请求示例

Bash

1curl --location 'https://qianfan.gz.baidubce.com/v2/chat/completions' \

2--header 'Content-Type: application/json' \

3--header 'Authorization: Bearer your-api-key' \

4--data '{

5 "model": "a9b9vg06_qwen_demo",

6 "messages": [

7 {"role": "system", "content": "你是一个有帮助的助手"},

8 {"role": "user", "content": "写一首七言绝句"}

9 ],

10 "temperature": 0.7,

11 "stream": false

12}'响应示例

JSON

1{

2 "id": "as-me95pc754k",

3 "object": "chat.completion",

4 "created": 1745402102,

5 "model": "a9b9vg06_qwen_demo:amv-7vw125yqvsrs",

6 "choices": [

7 {

8 "index": 0,

9 "message": {

10 "role": "assistant",

11 "content": "秋风吹叶满长安,\n夜雨敲窗梦不成。\n独坐小楼思往事,\n月明如水照孤城。"

12 },

13 "finish_reason": "stop"

14 }

15 ],

16 "usage": {

17 "prompt_tokens": 12,

18 "completion_tokens": 28,

19 "total_tokens": 40

20 }

21}