NVIDIA GPU资源监控

更新时间:2022-08-09

前言

本文介绍百度智能边缘BIE如何纳管使用NVIDIA GPU的边缘节点,并实现对NVIDIA GPU的资源监控。此处提到的使用NVIDIA GPU的边缘节点,一般特指使用了NVIDIA GPU AI加速卡的x86架构的GPU服务器,GPU AI加速卡可以是NVIDIA T4/P4/V100/A100/3090等。

依赖条件

要实现GPU资源监控,对于边缘节点有以下依赖条件:

- 边缘节点有NVIDIA GPU AI加速卡

- 边缘节点安装了NVIDIA Docker,具体安装方式参考官网。并且 docker runtime 设置为

nvidia。 - 边缘节点使用容器模式运行。

设置docker runtime为nvidia

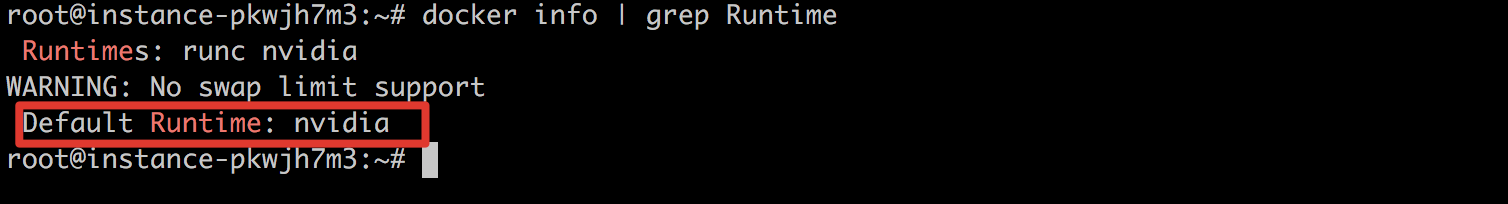

- 边缘节点安装docker以后,默认的runtime可能不是nvidia。可以通过执行

docker info | grep Runtime查看docker 的 runtime。

- 如果不是nvidia,此时需要更改Docker的daemon.json配置文件,文件路径通常为/etc/docker/daemon.json,添加如下配置即可。

Plain Text

1{

2 "default-runtime": "nvidia",

3 "runtimes": {

4 "nvidia": {

5 "path": "/usr/bin/nvidia-container-runtime",

6 "runtimeArgs": []

7 }

8 }

9}- 编辑完毕以后,重启docker,执行如下命令:

Plain Text

1sudo systemctl daemon-reload

2sudo systemctl restart docker操作指南

1.创建一个边缘节点,AI加速卡选择NVIDIA GPU,如下图所示:

说明:如果创建节点时没有选择AI加速卡,后续可以在边缘节点详情界面动态修改AI加速卡类型。

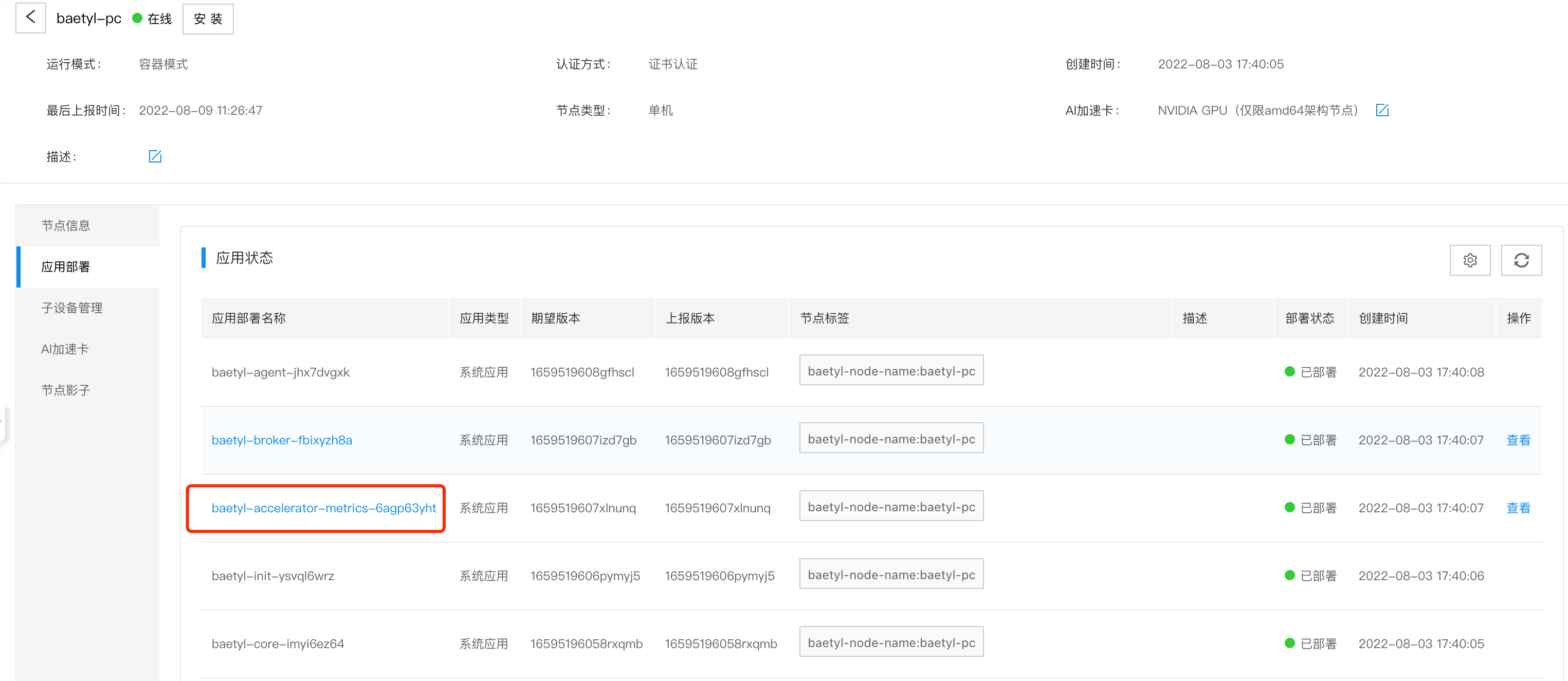

- 执行边缘节点安装操作,将在边缘节点上自动部署

baetyl-accelerator-metrics这个系统应用,用于采集GPU资源,如下图所示:

- 在边缘节点上查看NVIDIA GPU使用情况,执行

nvidia-smi命令,得到结果如下:

Plain Text

1nvidia-smi

2Tue Aug 9 12:55:58 2022

3+-----------------------------------------------------------------------------+

4| NVIDIA-SMI 470.42.01 Driver Version: 470.42.01 CUDA Version: 11.4 |

5|-------------------------------+----------------------+----------------------+

6| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

7| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

8| | | MIG M. |

9|===============================+======================+======================|

10| 0 NVIDIA GeForce ... Off | 00000000:17:00.0 Off | N/A |

11| 0% 36C P8 11W / 350W | 68MiB / 24259MiB | 0% Default |

12| | | N/A |

13+-------------------------------+----------------------+----------------------+

14+-----------------------------------------------------------------------------+

15| Processes: |

16| GPU GI CI PID Type Process name GPU Memory |

17| ID ID Usage |

18|=============================================================================|

19| 0 N/A N/A 1193 G /usr/lib/xorg/Xorg 56MiB |

20| 0 N/A N/A 1616 G /usr/bin/gnome-shell 9MiB |

21+-----------------------------------------------------------------------------+- 进入节点详情,点击AI加速卡,可以看到AI加速卡详情,如下图所示:

5.边缘端与云端指标映射信息如下表所示:

| 边缘端 | 云端 | 数值 | 备注 |

|---|---|---|---|

| GPU | 编号 | 1 | |

| Name | 名称 | NVIDIA GeForce RTX 3090 | |

| Temp | 温度(℃) | 38 | |

| Pwr | 能耗(W) | 13.694 | |

| Memory-Usage | 显存使用情况 | 52.25 MiB/23.69 GiB | |

| 无 | GPU使用率 | 0.22 | 云端计算值,实际使用显存/显存容量 |