通过AI中台转换模型并下发至边缘

更新时间:2022-12-01

本文介绍如何在AI中台的模型中心导入原始模型,转换成适配NVIDIA Jetson的模型文件,并下发至设备边缘。

前提条件

- 有一个可测试的边缘节点设备

- 边缘节点连接至云端

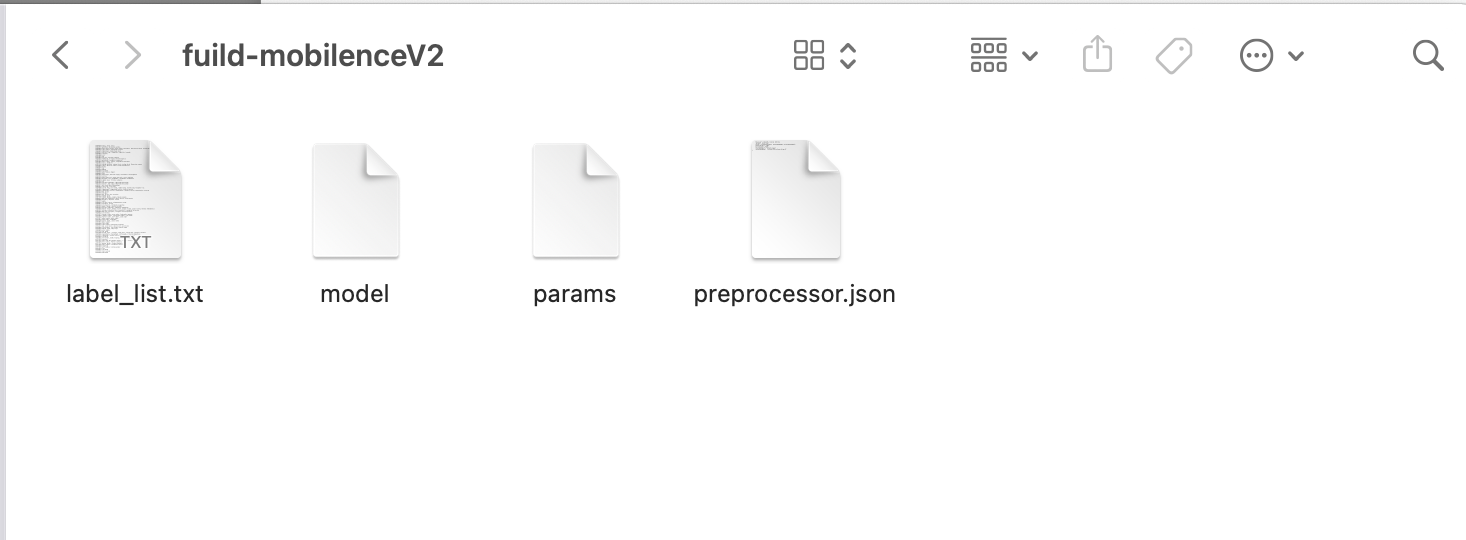

- 有一个模型,本实验用的是一个图像分类模型fuild-mobilenceV2.zip。该模型支持识别检测猴子、鸡、狗、猫等上百种生物

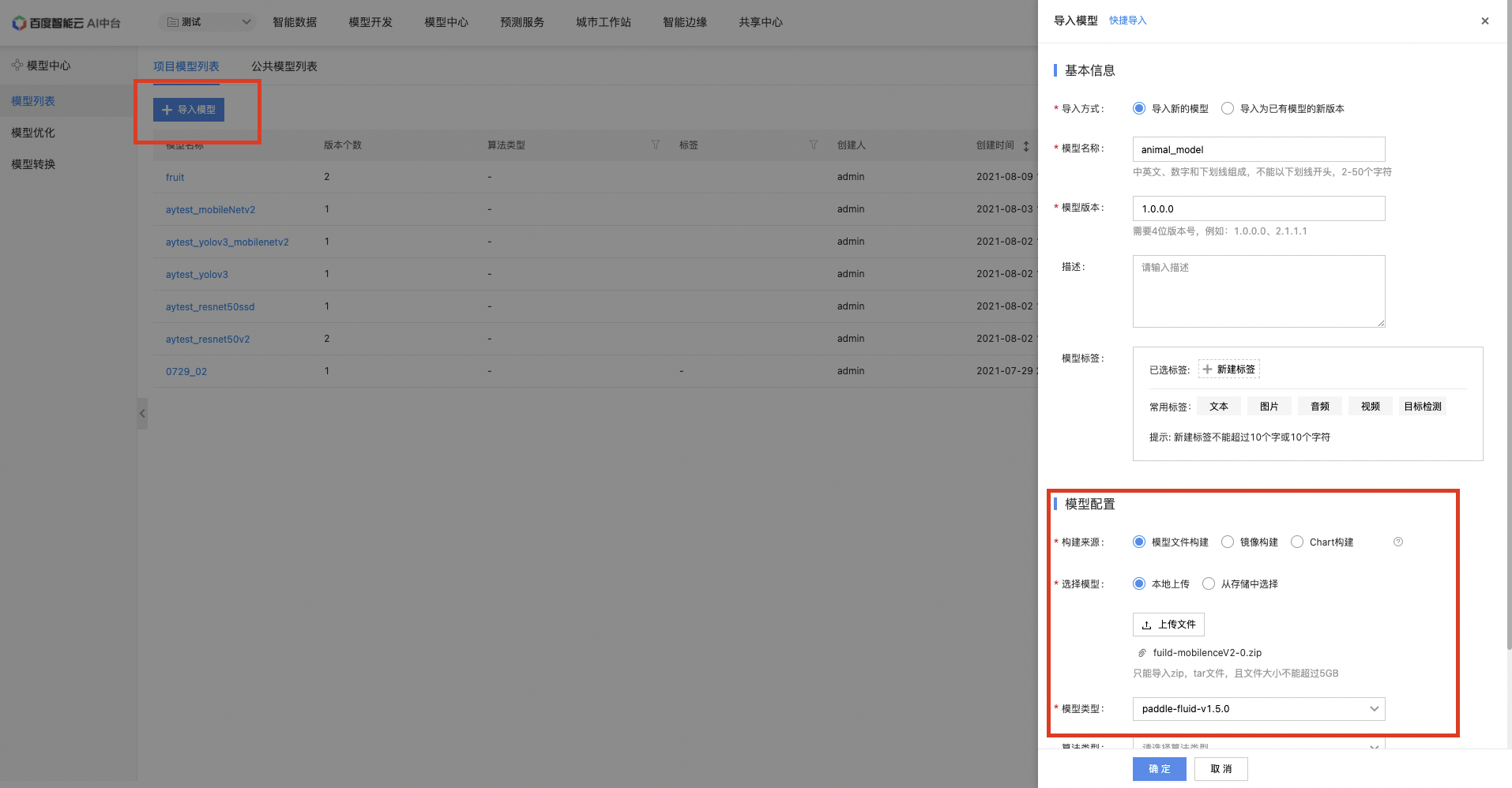

在AI中台模型仓库导入模型

打开AI中台控制台,进入「模型中心」,选中「模型列表」,点击上传模型。 将下载好的模型上传,配置如图所示:

- 模型类型:这个原始模型的模型类型,此处选择paddle-fluid-v1.5.0

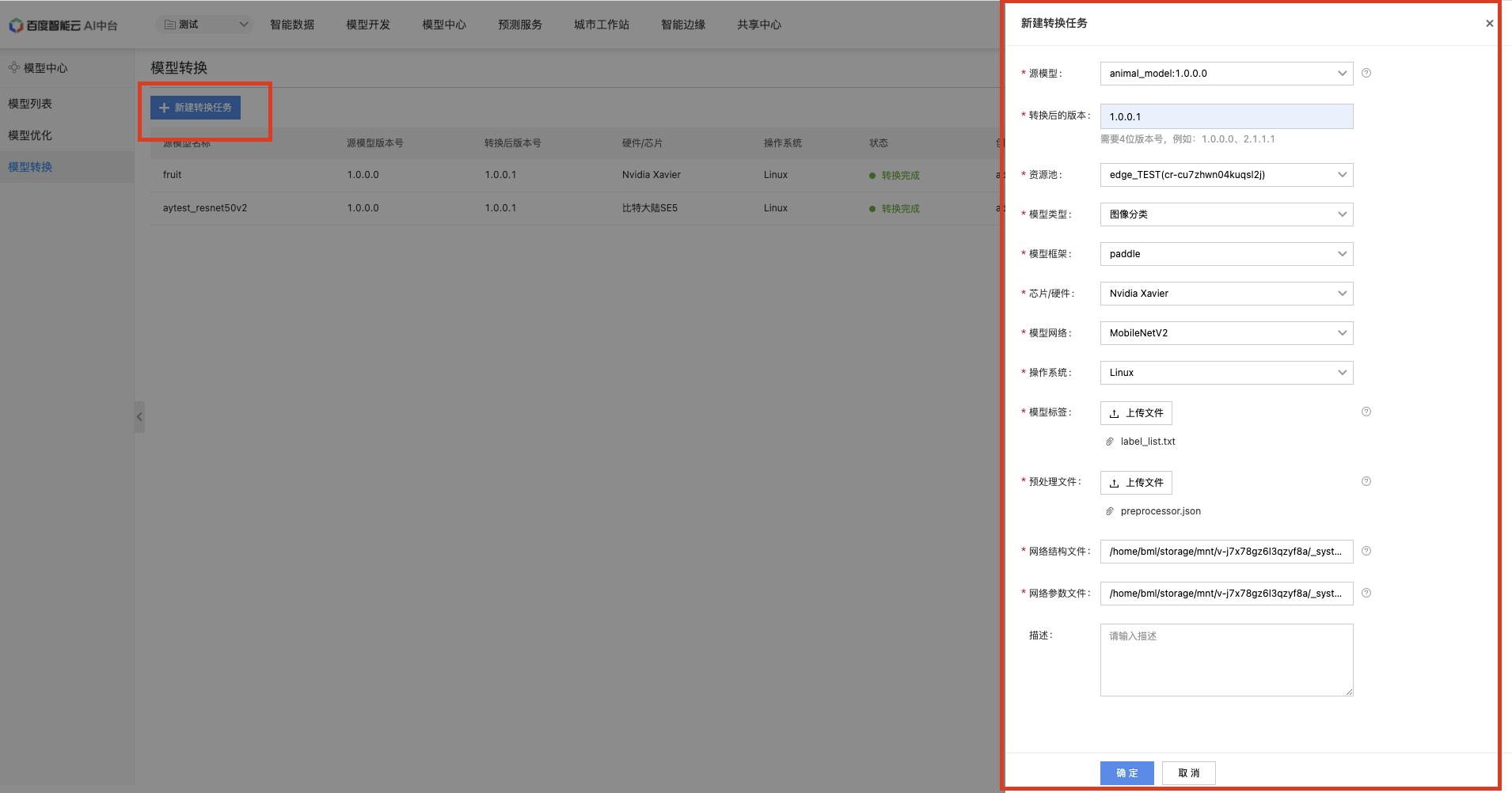

转换模型

导入的原始模型并不适配NVIDIA Jetson类型设备,如果希望模型在NVIDIA Jetson设备上运行,需要进行模型转换操作。

进入「模型中心」,选中「模型转换」,点击「新建转换任务」,在弹出框当中进行配置,如下图所示:

- 源模型:选择上一步导入的模型,即

animal_model:1.0.0.0 - 转换后的版本:模型转换以后,将生成新的模型版本,此处设置为

1.0.0.1 - 资源池:选择可用资源池

- 模型类型:源模型的模型类型,为

图像分类 - 模型框架:源模型的模型框架,为

paddle - 模型网络:这个源模型的模型网络,为MobileNetV2

-

目标设备信息:下面两个是填写目标设备信息,即转换后的模型运行环境信息。

- 操作系统:选择linux,支持ubuntu、centos等常见linux发行版

- 芯片/硬件:这个是设置这个模型需要转换成在哪种类型设备上运行,此处选择NVIDIA Xavier,也可以使用通用ARM,因为jetson设备也是通用ARM设备。

-

模型转换参数:来自于源模型压缩包。

- 模型标签:使用源模型的

label_list.txt - 预处理文件:使用源模型的

processor.json - 网络结构文件:使用源模型的

model - 网络参数文件:使用源模型的

params

- 模型标签:使用源模型的

部署到端设备

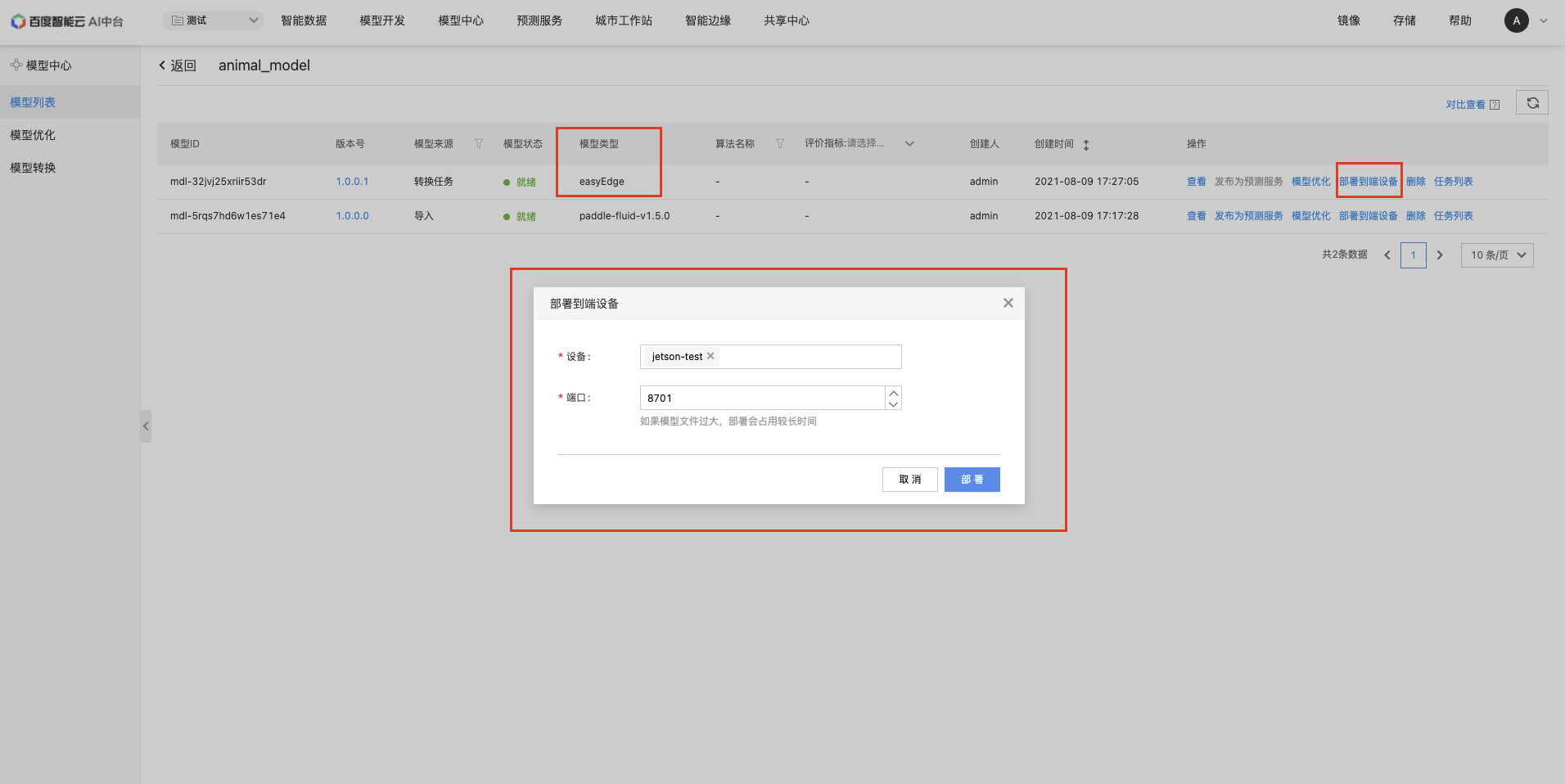

模型转换成功后,我们需要将它部署到NVIDIA Jetson上。进入「模型中心」,选中「模型列表」

选中转换好的模型,转换好的模型类型为easyedge。点击【部署到端设备】.选中在智能边缘创建的边缘节点,端口号输入8701.点击部署后,该模型将自动以应用的形式部署到端设备上。

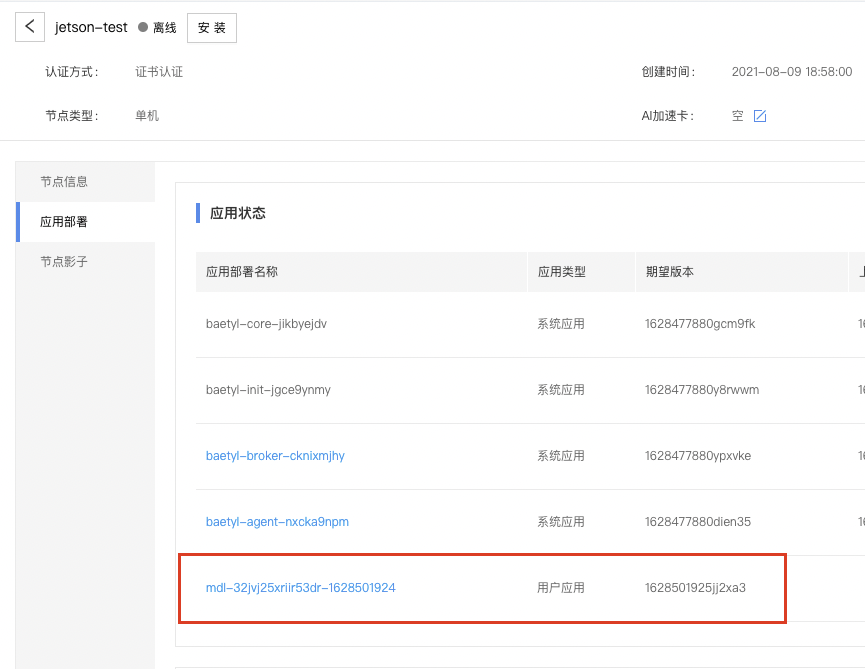

进入「智能边缘」控制台,选中对应的节点,可以看到应用已经出现在应用列表。当节点连上云端时,会自动将该应用部署到节点上。

验证

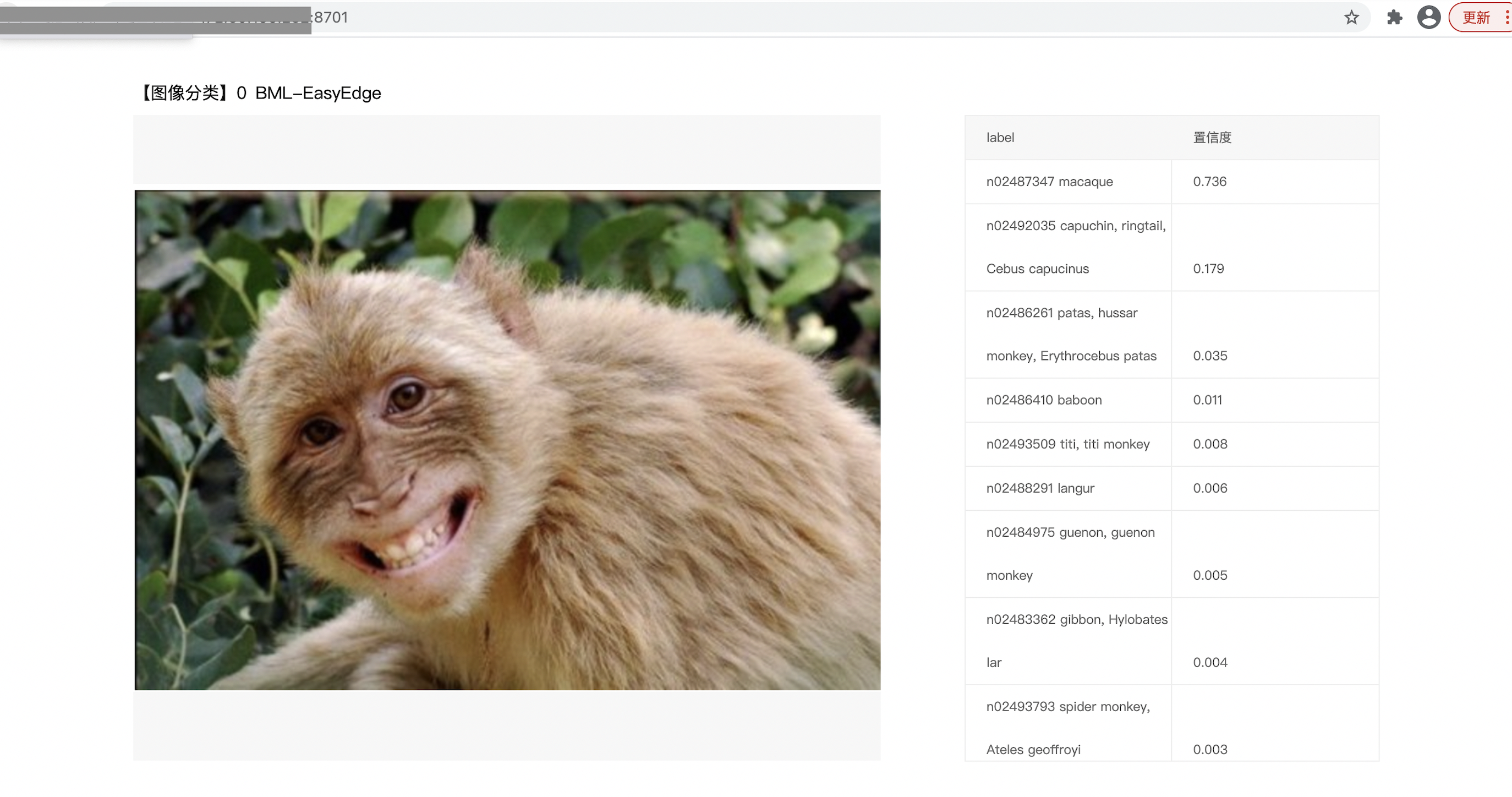

边缘侧应用部署成功后,调用部署到边缘侧的AI服务来验证这个demo。在浏览器输入:<边缘ip>:8701。 上传检测的图像,可以看到成功识别出猕猴。