- 什么是AI大底座?

- AI大底座产品创新图谱

- 两大平台

- 三大核心能力

- 为什么选择AI大底座?

- 通过AI大底座您可以实现

- 我们如何帮助客户成功?

- 相关产品

- 联系我们

什么是AI大底座?

AI大底座帮助企业从上云,进入到用数、赋智的快车道,降低AI产业应用的门槛,提升效率让企业可以把精力聚焦在业务上,充分挖掘智能化带来的价值,实现产业与技术融合创新

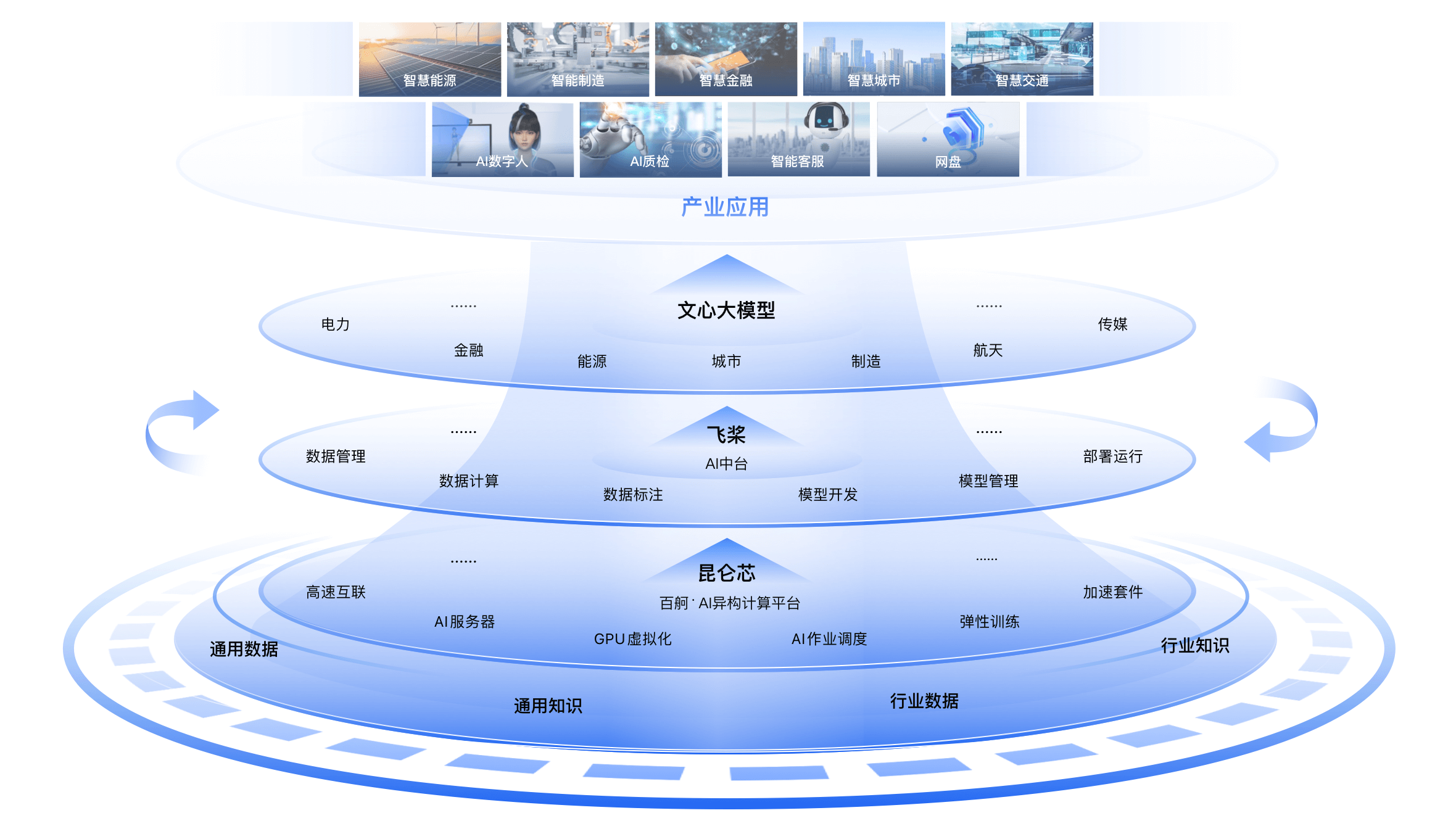

AI大底座产品创新图谱

百度AI大底座由AI IaaS层(百舸AI异构计算平台),AI PaaS层(AI中台)两大部分组成

两大平台

百度百舸 · AI异构计算平台

包含AI计算、AI存储、AI加速、AI容器四大核心套件,具有高性能、高弹性、高速互联、高性价比等特性。为AI场景提供软硬一体解决方案,充分汲取百度异构计算平台多年的技术沉淀和实践经验,深度融合推荐、无人驾驶、生命科学、NLP场景。了解详情

三大核心能力

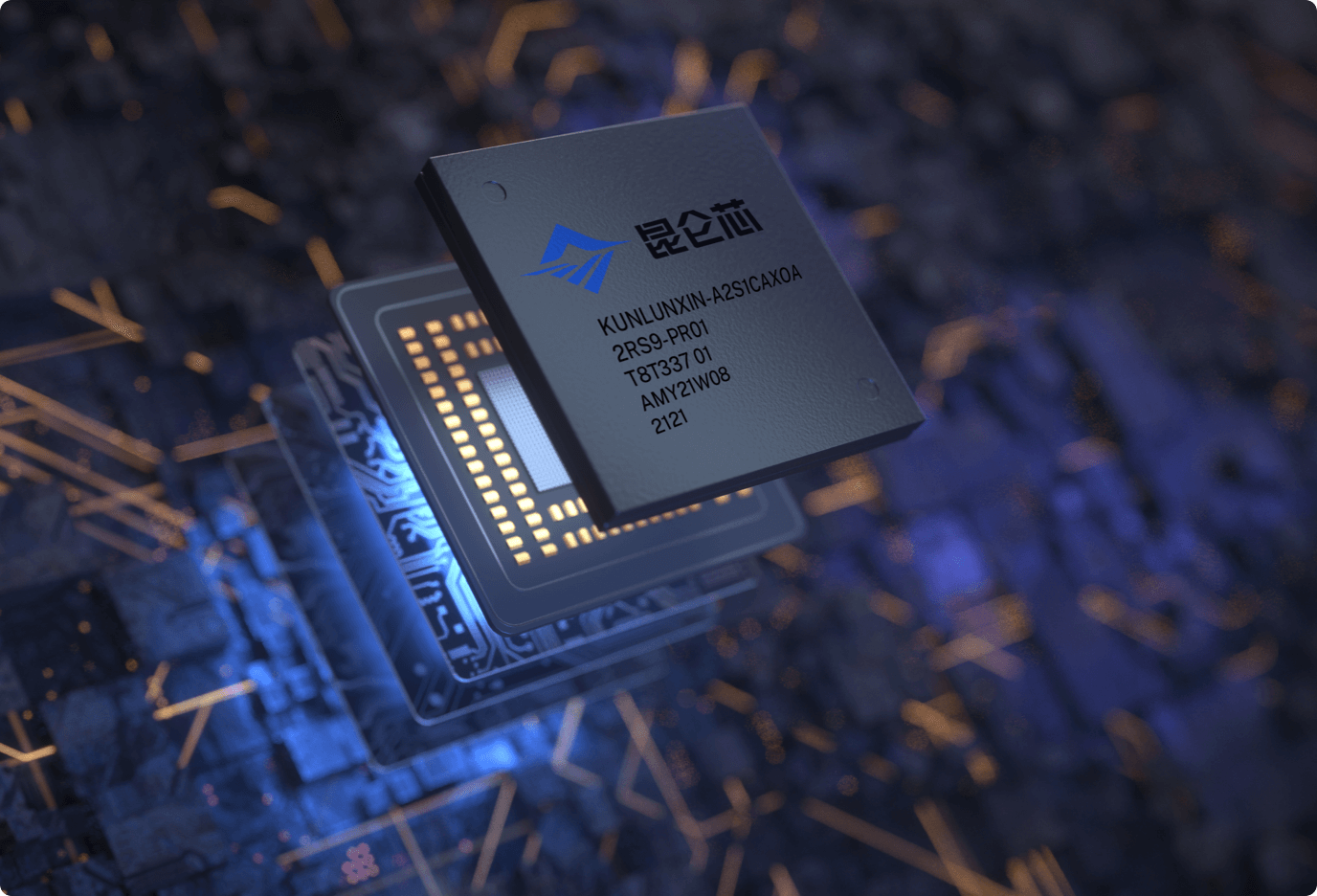

昆仑芯2代AI芯片

基于新一代自研架构昆仑芯XPU-R而设计,是国内首款采用GDDR6显存的通用AI芯片。昆仑芯2代AI芯片聚焦高性能、通用性和易用性。相比1代产品,昆仑芯2代AI芯片的通用计算核心算力提升2-3倍,可为数据中心高性能计算提供强劲AI算力。

核心技术

新一代昆仑芯自研架构

采用XPU-R架构,通用性和性能显著提升

算力强大

256 TOPS@INT8,128 TFLOPS@FP16

技术领先

7nm先进工艺,GDDR6高速显存

功能完备

支持虚拟化,芯片间互联和视频编解码

为什么选择AI大底座?

提供全要素、端到端的AI完整解决方案

AI大底座面向企业AI开发的全生命周期提供的完整解决方案。百度在AI生产全要素的各层都具有自主可控的核心技术和产品。只有具备全要素的核心技术,才能面向真实业务场景进行端到端的全流程调优,为企业提供极致效能。

实现“自我升级”

在面向实际业务场景时,AI生产全要素中的每一层能力都会得到很多真实业务的反馈,百度AI大底座基于大模型特性,形成平台化反馈闭环机制,通过反馈闭环,持续迭代优化,继而不断提升应用效果。

通过AI大底座您可以实现

集约化建设

- 通过集中资源获得大算力和大数据,支持大模型训练和推理,以及高并发的应用负载,集中资源办大事。

高性能应用

- 将AI应用深入到生产过程的毛细血管中解决实际问题,实现高性能的模型压缩、加速和适配并支持高效开发和应用。

持续性增强

- 面对千变万化的实际业务情况,通过持续迭代、循环增强提升应用的整体效果。

我们如何帮助客户成功?

相关产品

GPU云服务器

配备GPU的云端服务器,可以为机器学习、高性能计算、图形图像渲染等计算密集型应用提供加速处理能力。根据需求场景的不同,既可提供弹性的GPU云服务器,也可提供高性能的GPU裸金属服务器,助力您的业务创新,提升竞争优势。

并行文件存储PFS

百度智能云PFS提供完全托管、简单可扩展的并行文件存储服务,针对高性能计算场景提供亚毫秒级的访问能力、高IOPS及高吞吐的数据读写请求能力,适用于AI训练、自动驾驶、大数据分析、视频渲染等高性能计算场景。 申请开通

云原生AI

云原生AI基于百度智能云容器引擎(CCE)支持GPU显存和算力的共享与隔离,同时集成多种主流深度学习框架,通过对AI任务的编排、管理,提供深度学习训练服务,帮助企业客户提高GPU资源使用效率和提升AI训练速度,快速降本增效。