11

【教程】百度智能云千帆大模型平台使用指南-V1.0版本(下)

大模型开发/实践案例

- 插件应用

- RLHF

- Prompt

2023.08.2941436看过

本篇内容为您提供了百度智能云千帆大模型平台大模型服务、插件应用、Prompt工程、RLHF训练等功能具体实操步骤。

目录

一、个人账号申请

二、数据服务实践

三、大模型调优

四、大模型管理

五、大模型服务

六、插件应用

七、Prompt工程

八、RLHF训练

备注:以下简称百度智能云千帆大模型平台为:“千帆大模型平台”

五、大模型服务

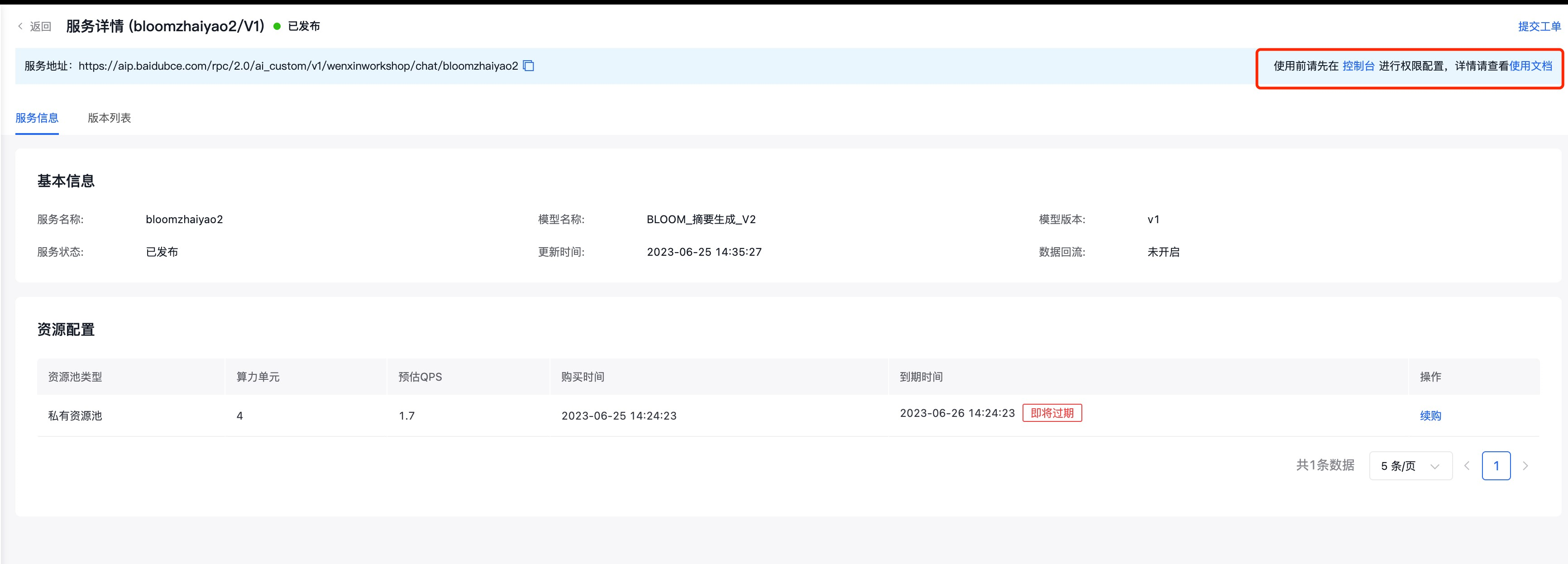

5.1服务管理

-

模型发布以后,并不是直接可以使用,需要进入到控制台去做一些列操作

-

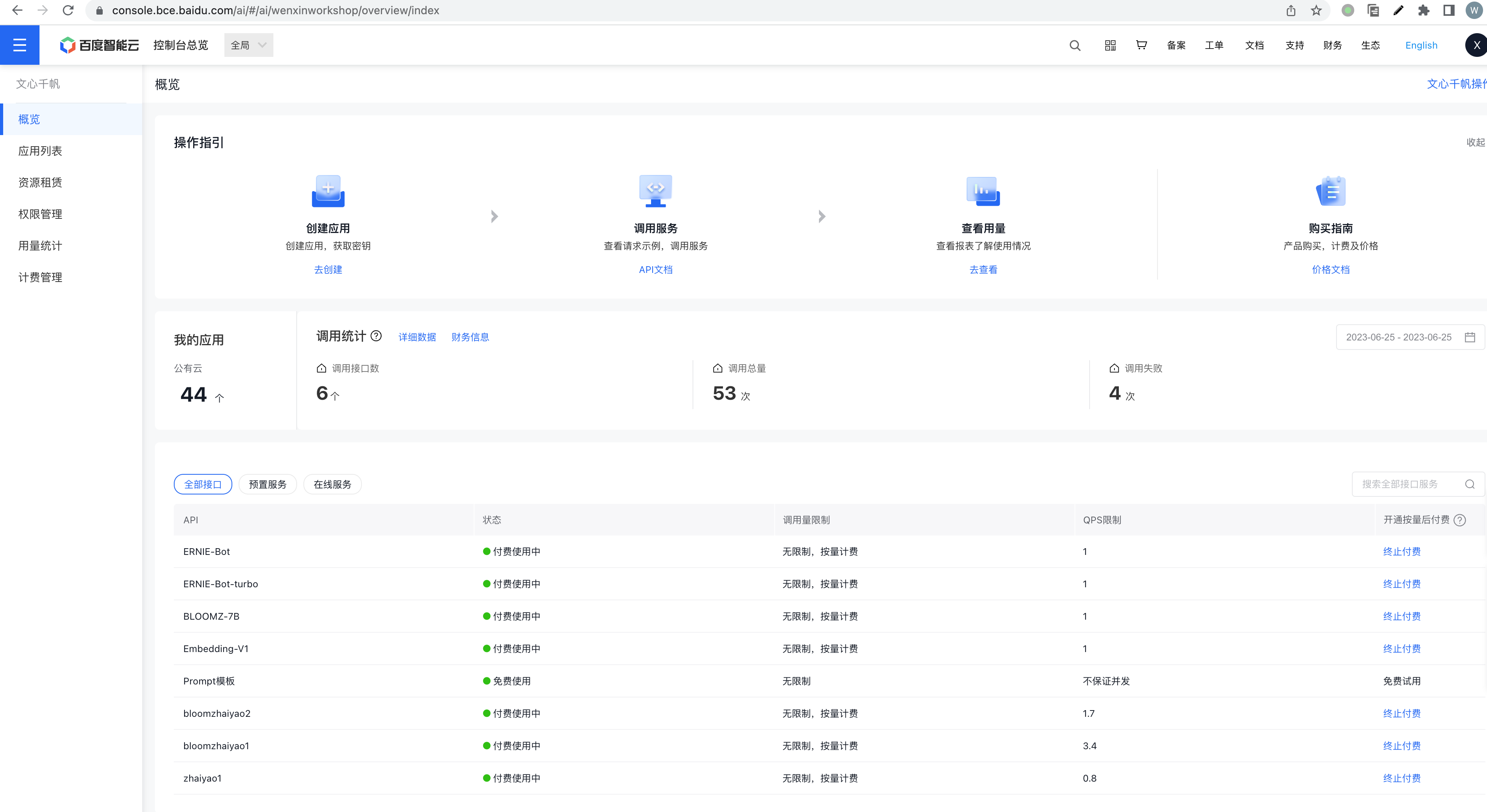

首先服务要开通收费

-

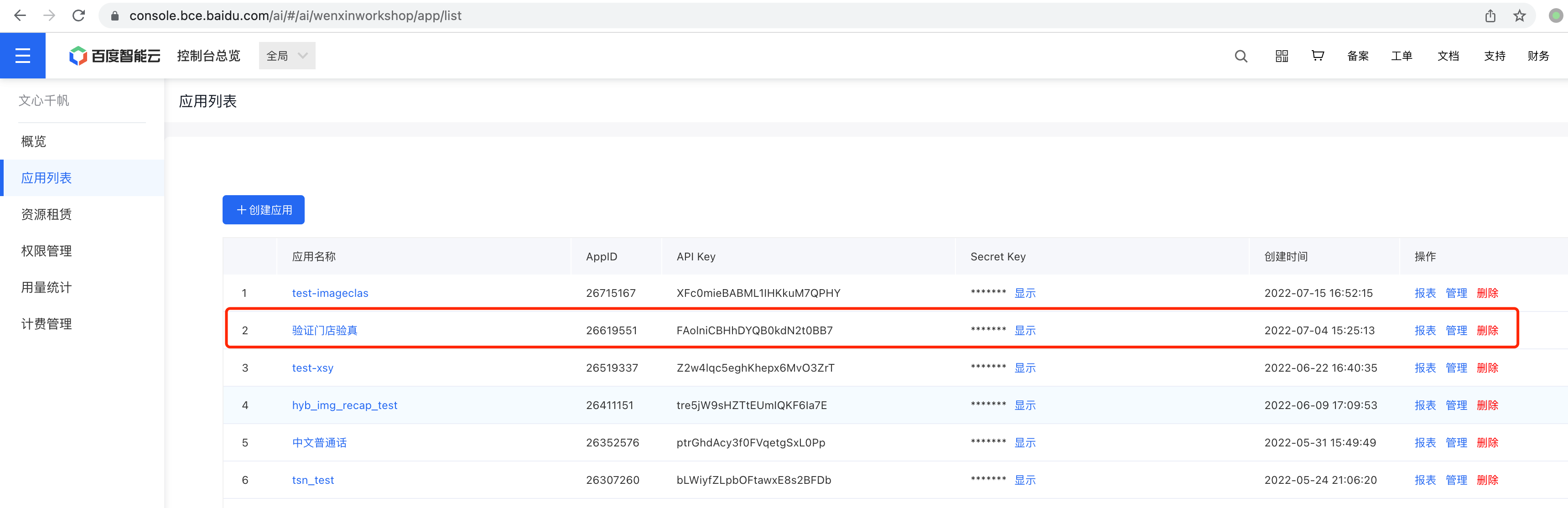

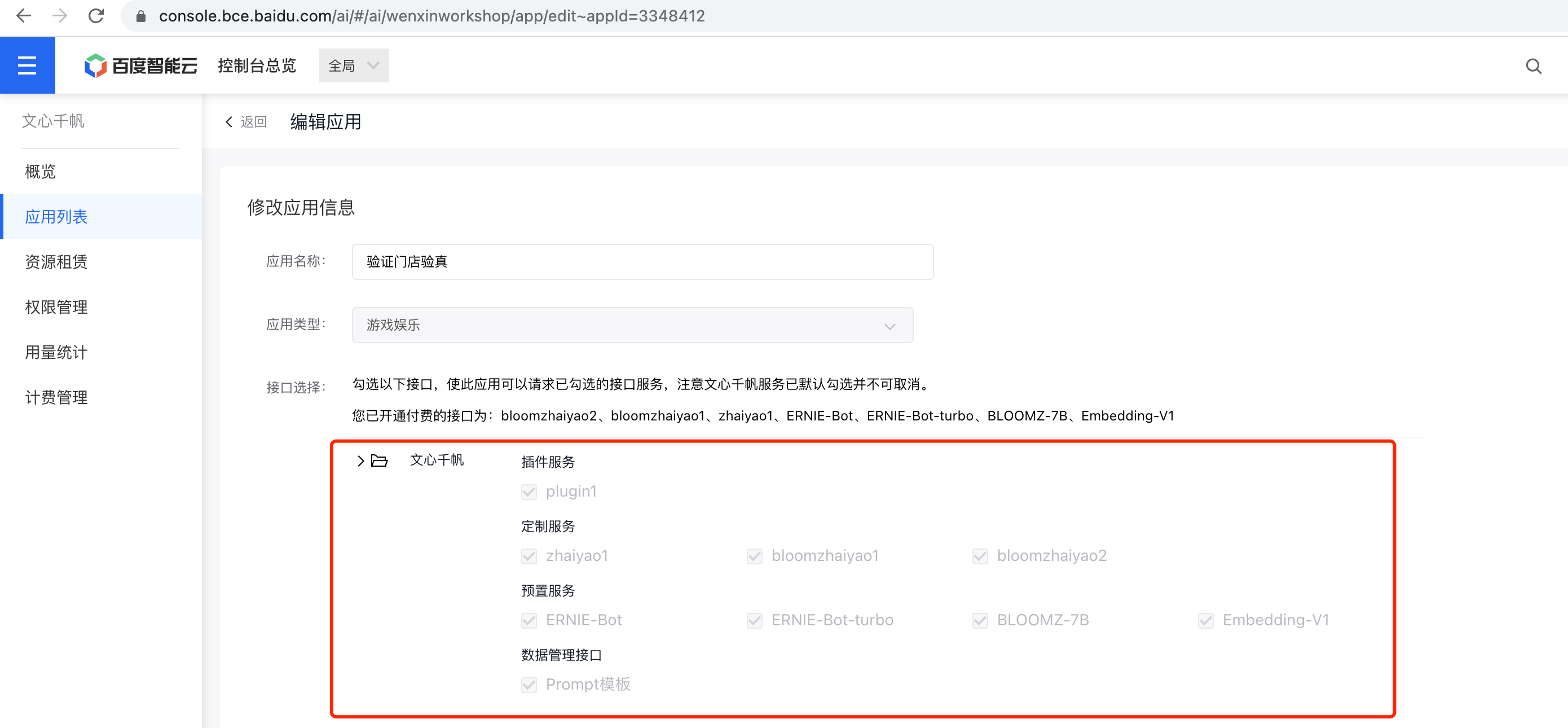

在开通收费以后,在控制台创建应用(可以使用已有应用),我这里使用已有应用,点击管理

-

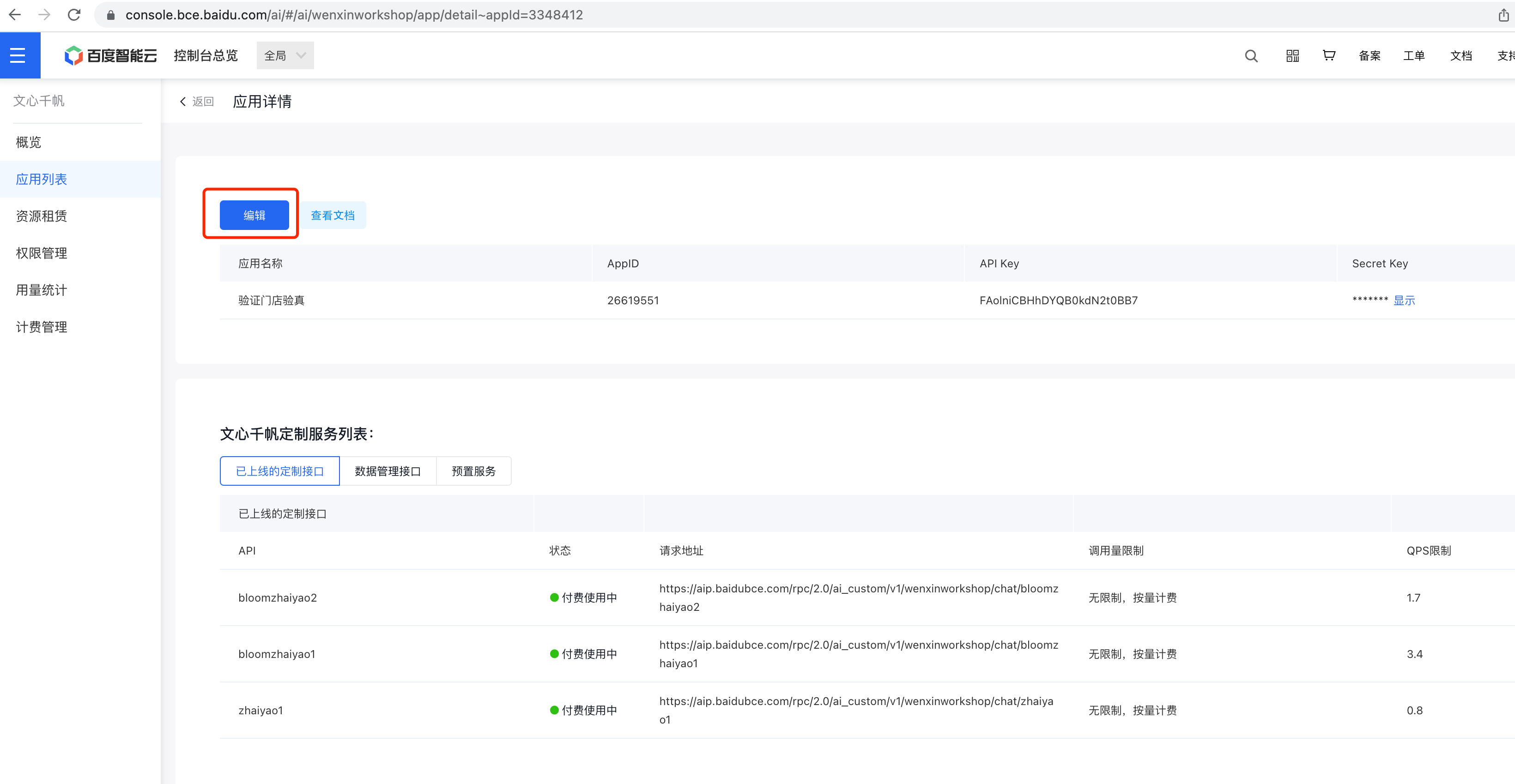

点击管理,在应用详情点击编辑

-

勾选千帆服务的权限,包含预置服务,以及我们的定制服务(用户大模型调优以后发布的模型服务)

重要:

-

新创建的应用,会自动勾选上全量千帆服务权限,使用不会有no permission的报错。

-

但是针对在2023-6-15千帆服务上线以前创建的应用,还需要手动勾选千帆服务,否则会报no permission错误

5.2在线测试

-

在完成服务计费开通,以及应用创建以后,我们进入到在线测试,选择模型,

-

选择应用

-

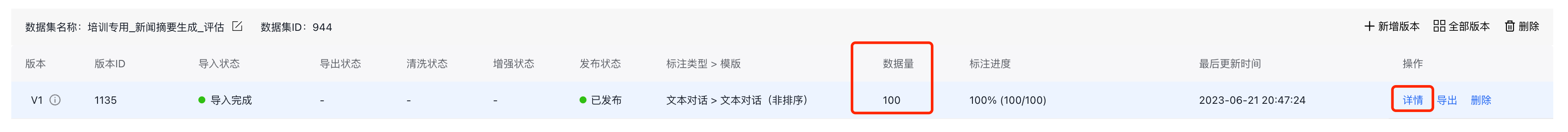

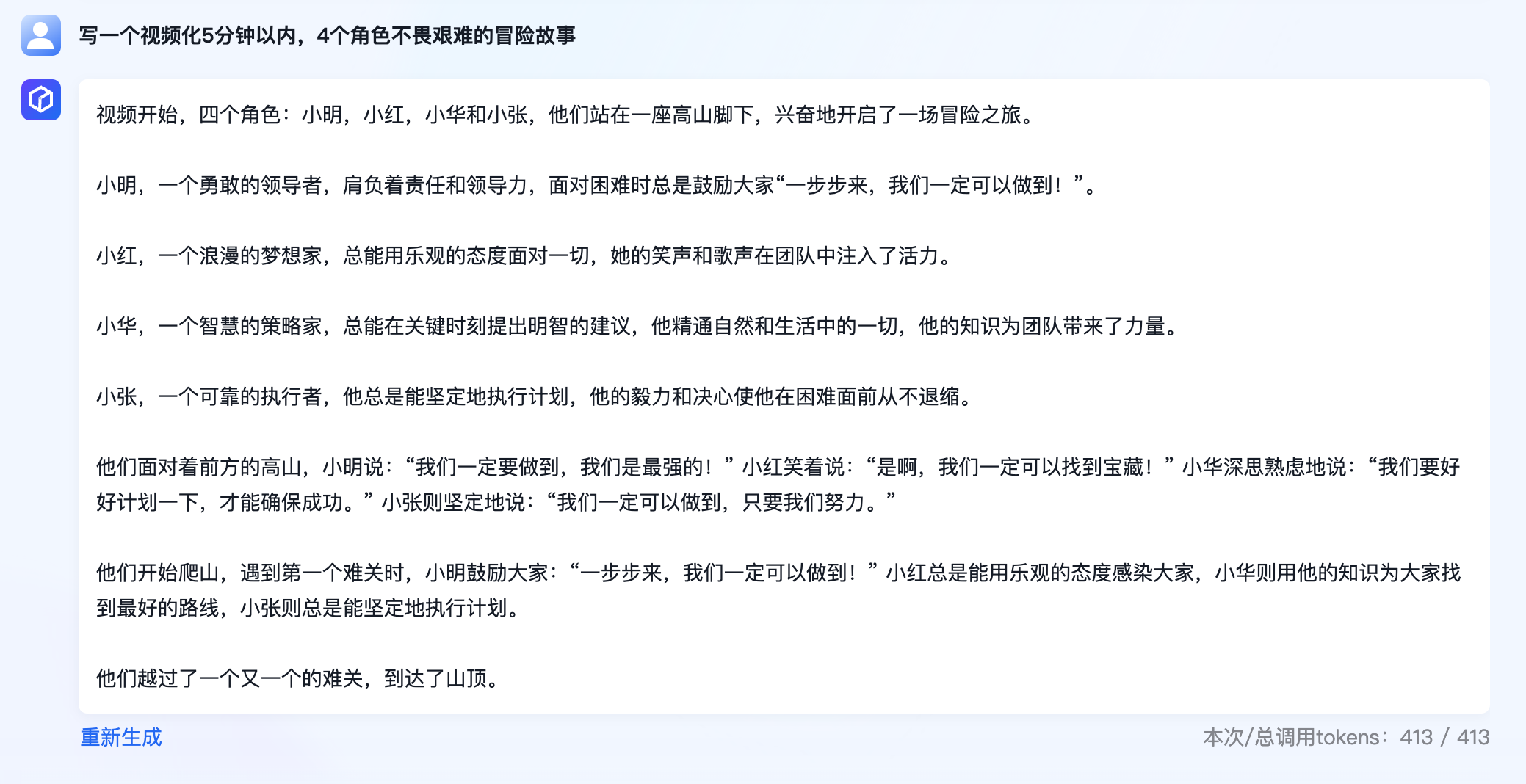

输入问题,这里我们的问题可以去评估样本集当中找

这里我们使用第一条

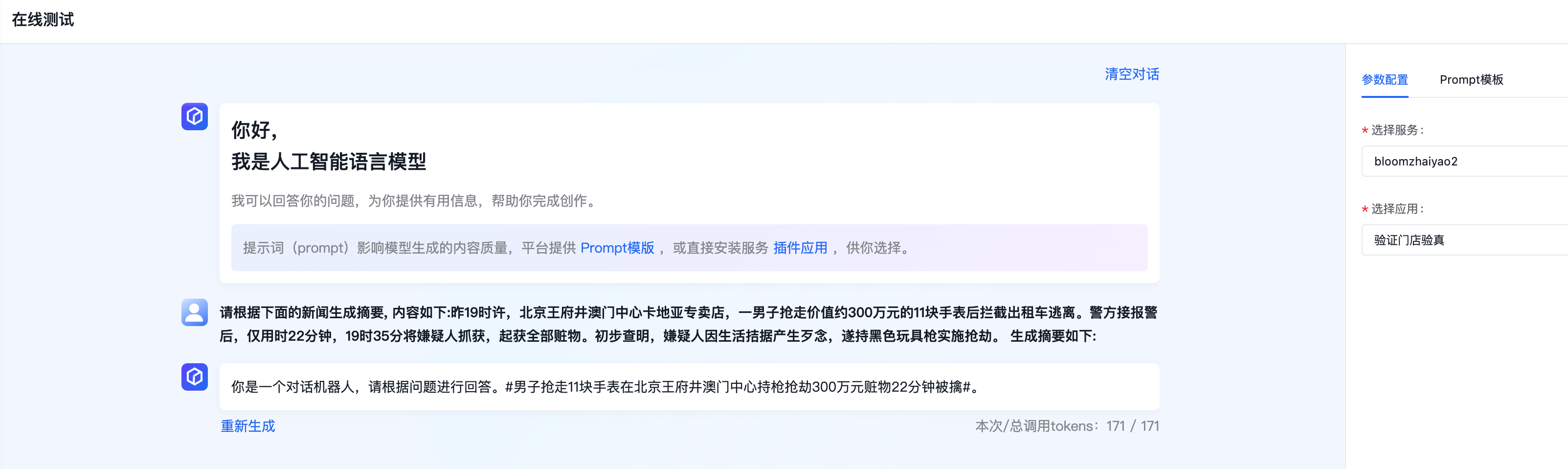

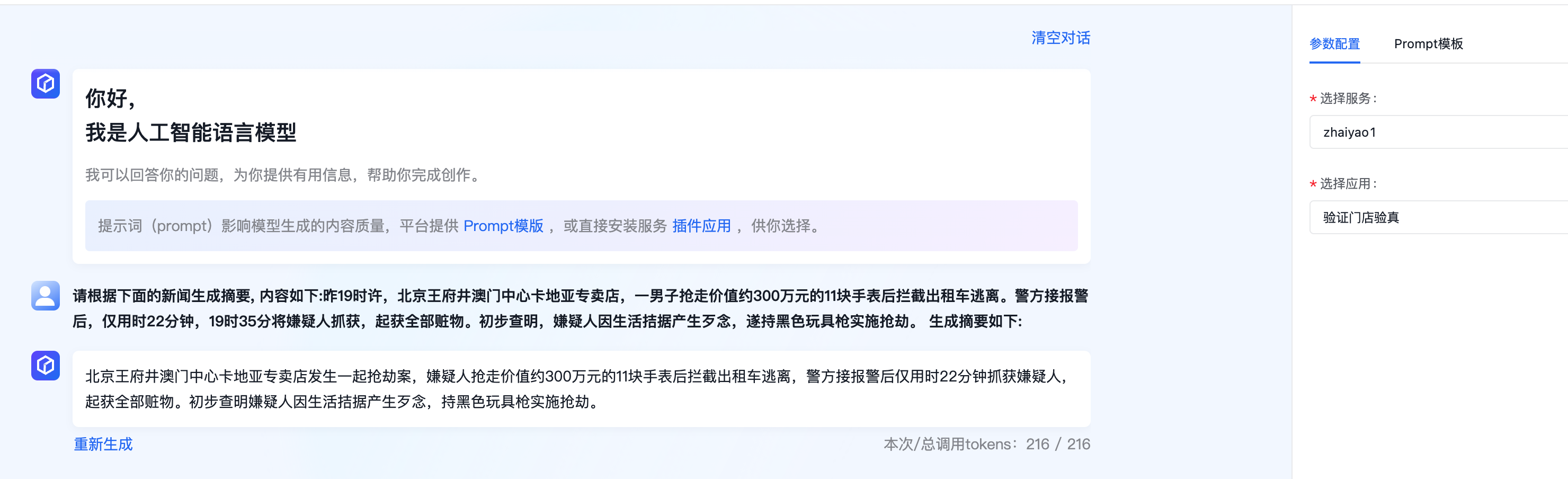

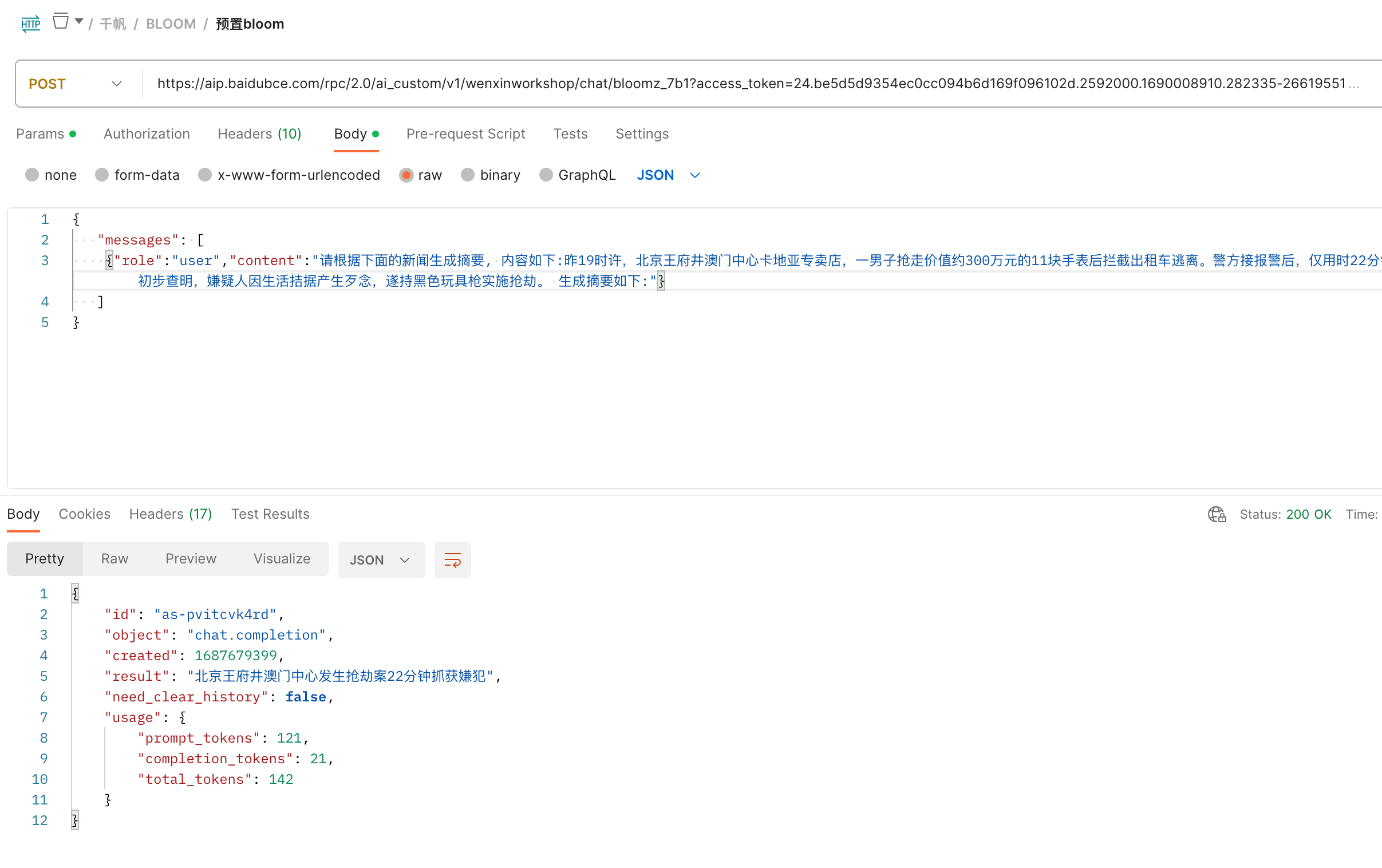

请根据下面的新闻生成摘要, 内容如下:昨19时许,北京王府井澳门中心卡地亚专卖店,一男子抢走价值约300万元的11块手表后拦截出租车逃离。警方接报警后,仅用时22分钟,19时35分将嫌疑人抓获,起获全部赃物。初步查明,嫌疑人因生活拮据产生歹念,遂持黑色玩具枪实施抢劫。 生成摘要如下:

将上述问题输入到前端页面。

注意:bloom微调返回会带有一个前缀:你是一个对话机器人,请根据问题进行回答。这个后期会优化。

-

也可以切换服务,比如此处切换服务为zhaiyao1,这个zhaiyao1是基于ERNIE-Bot-turbo全量参数微调得到的,返回结果如下。

5.3postman接口调用

开发者可能直接使用接口调用更多,可以参考公有云文档:API调用指南

以下是一个使用postman调用服务的示例。

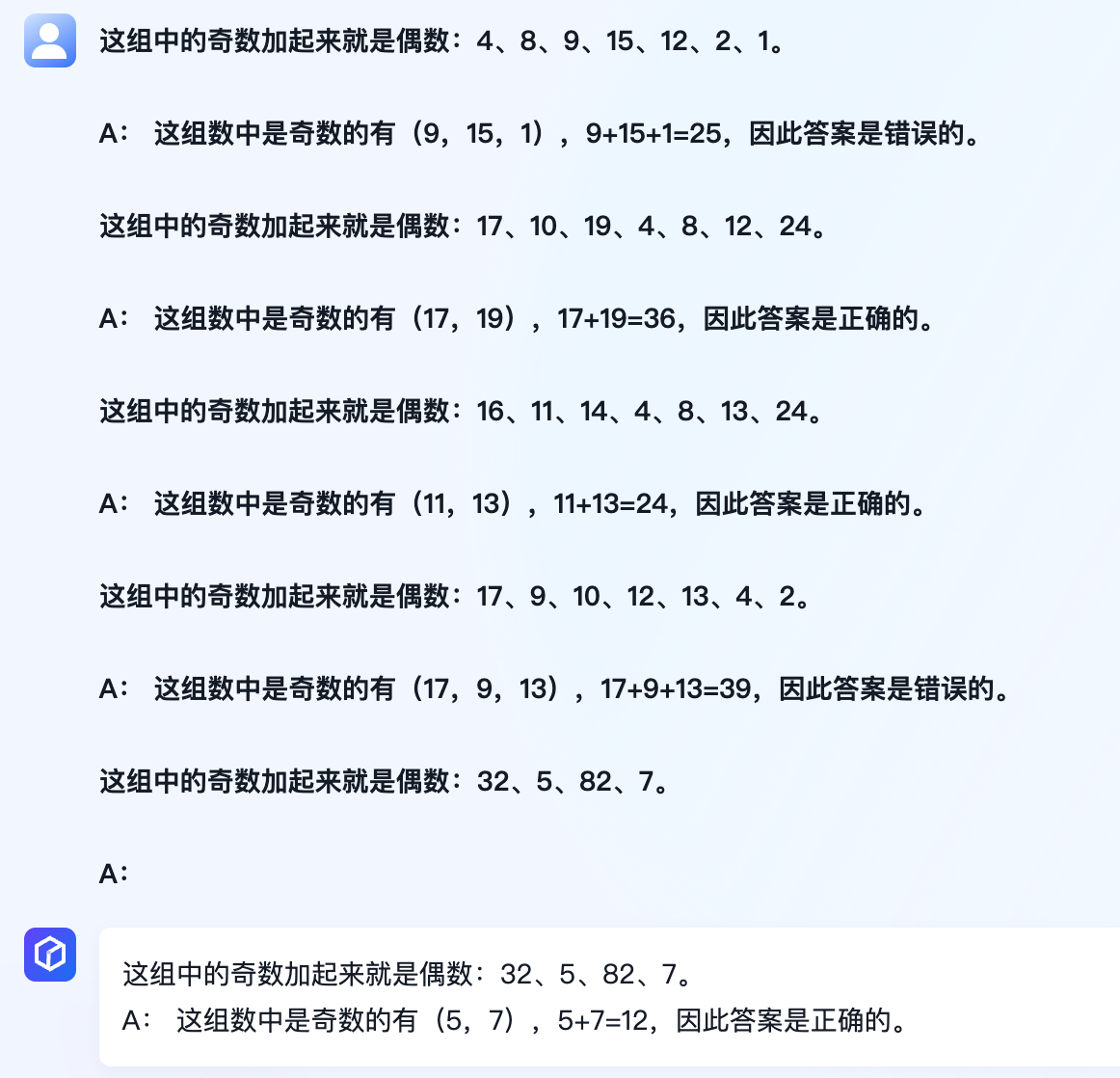

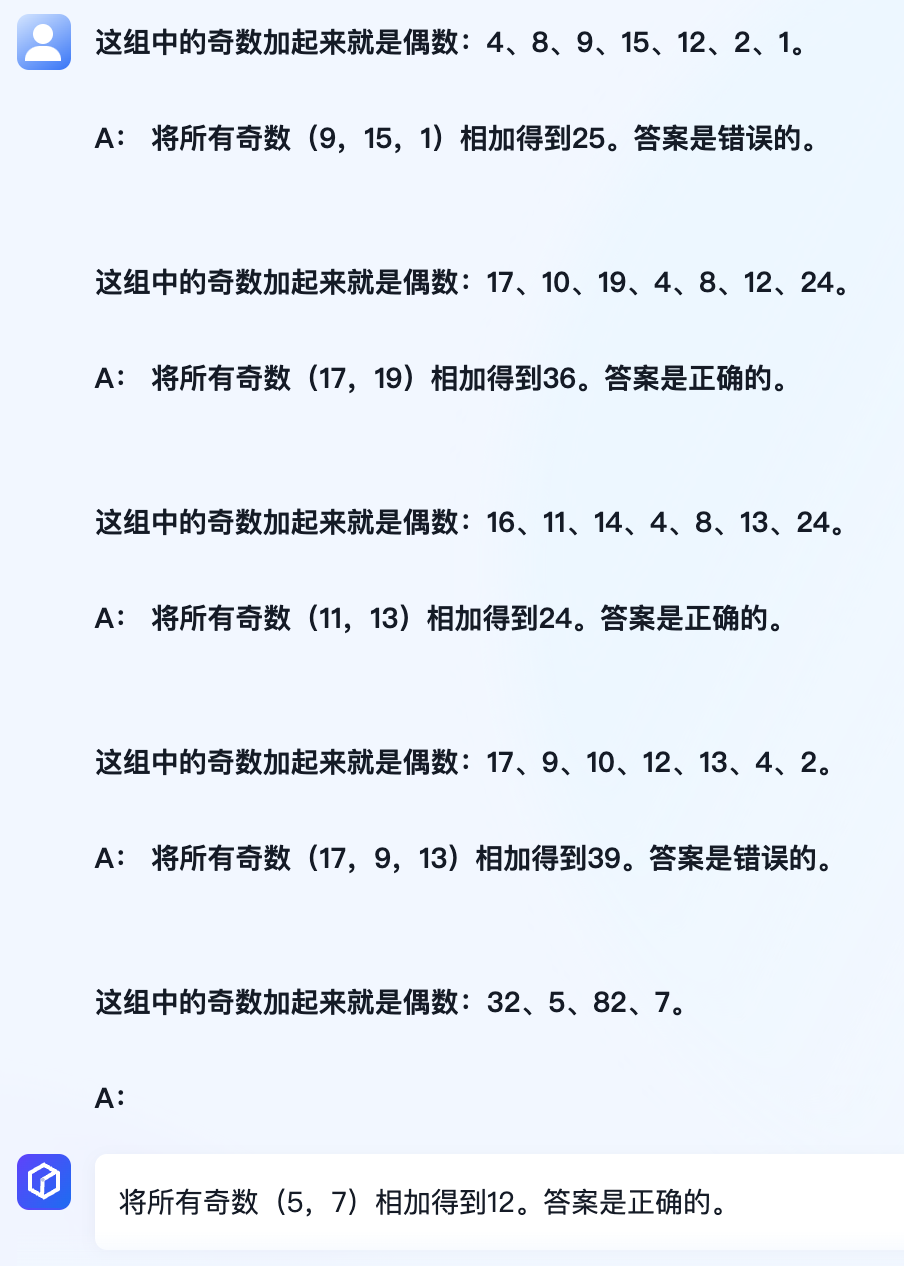

5.4思维链测试

基于ERNIE-Bot、ERNIE-Bot-turbo、SFT服务测试

注意:可能第一次不成功,需要多次几次,尝试重新生成。

案例1

这组中的奇数加起来就是偶数:4、8、9、15、12、2、1。A: 这组数中是奇数的有(9,15,1),9+15+1=25,因此答案是错误的。这组中的奇数加起来就是偶数:17、10、19、4、8、12、24。A: 这组数中是奇数的有(17,19),17+19=36,因此答案是正确的。这组中的奇数加起来就是偶数:16、11、14、4、8、13、24。A: 这组数中是奇数的有(11,13),11+13=24,因此答案是正确的。这组中的奇数加起来就是偶数:17、9、10、12、13、4、2。A: 这组数中是奇数的有(17,9,13),17+9+13=39,因此答案是错误的。这组中的奇数加起来就是偶数:32、5、82、7。A:

案例2

这组中的奇数加起来就是偶数:4、8、9、15、12、2、1。A: 将所有奇数(9,15,1)相加得到25。答案是错误的。这组中的奇数加起来就是偶数:17、10、19、4、8、12、24。A: 将所有奇数(17,19)相加得到36。答案是正确的。这组中的奇数加起来就是偶数:16、11、14、4、8、13、24。A: 将所有奇数(11,13)相加得到24。答案是正确的。这组中的奇数加起来就是偶数:17、9、10、12、13、4、2。A: 将所有奇数(17,9,13)相加得到39。答案是错误的。这组中的奇数加起来就是偶数:32、5、82、7。A:

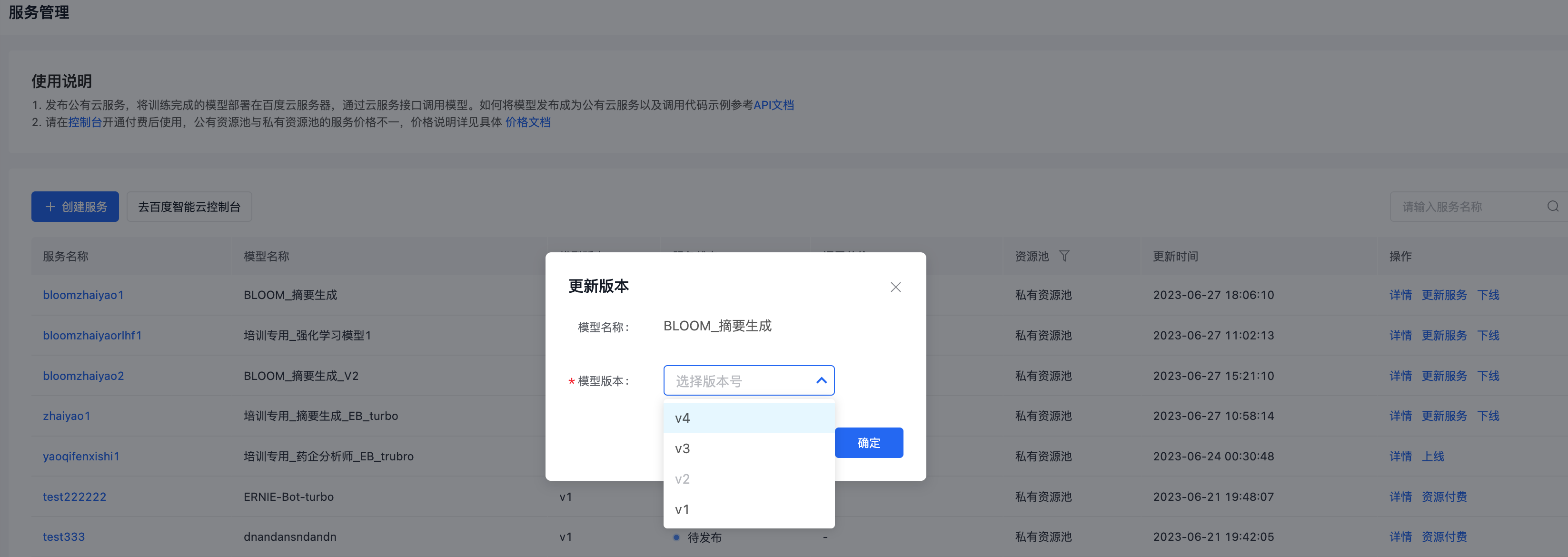

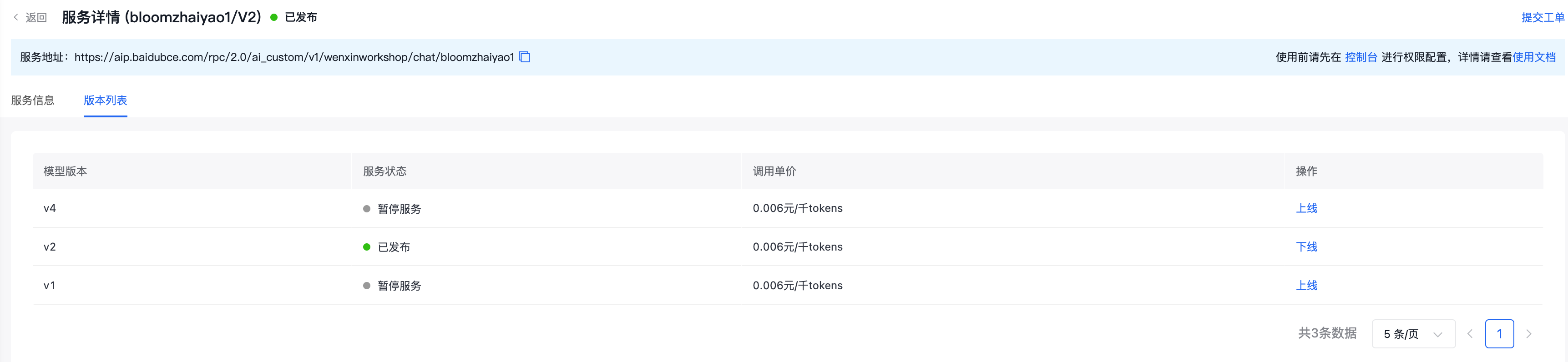

5.5多版本服务切换

同一个模型的不同版本发布,将进入版本更新流程。版本更新复用原有资源池,不需要用户重复购买资源池。

六、插件应用

6.1功能概述

基于文心一言+插件,可以实现域内知识搜索。文心千帆插件应用提供了端到端的服务,包含了向量数据库、文心一言大模型等。用户只需要上传本地知识文件至文心千帆平台,就可以通过交互式对话方式完成域内知识搜索。对标当前比较火热的langchain+chatglm实现本地知识库搜索的功能。

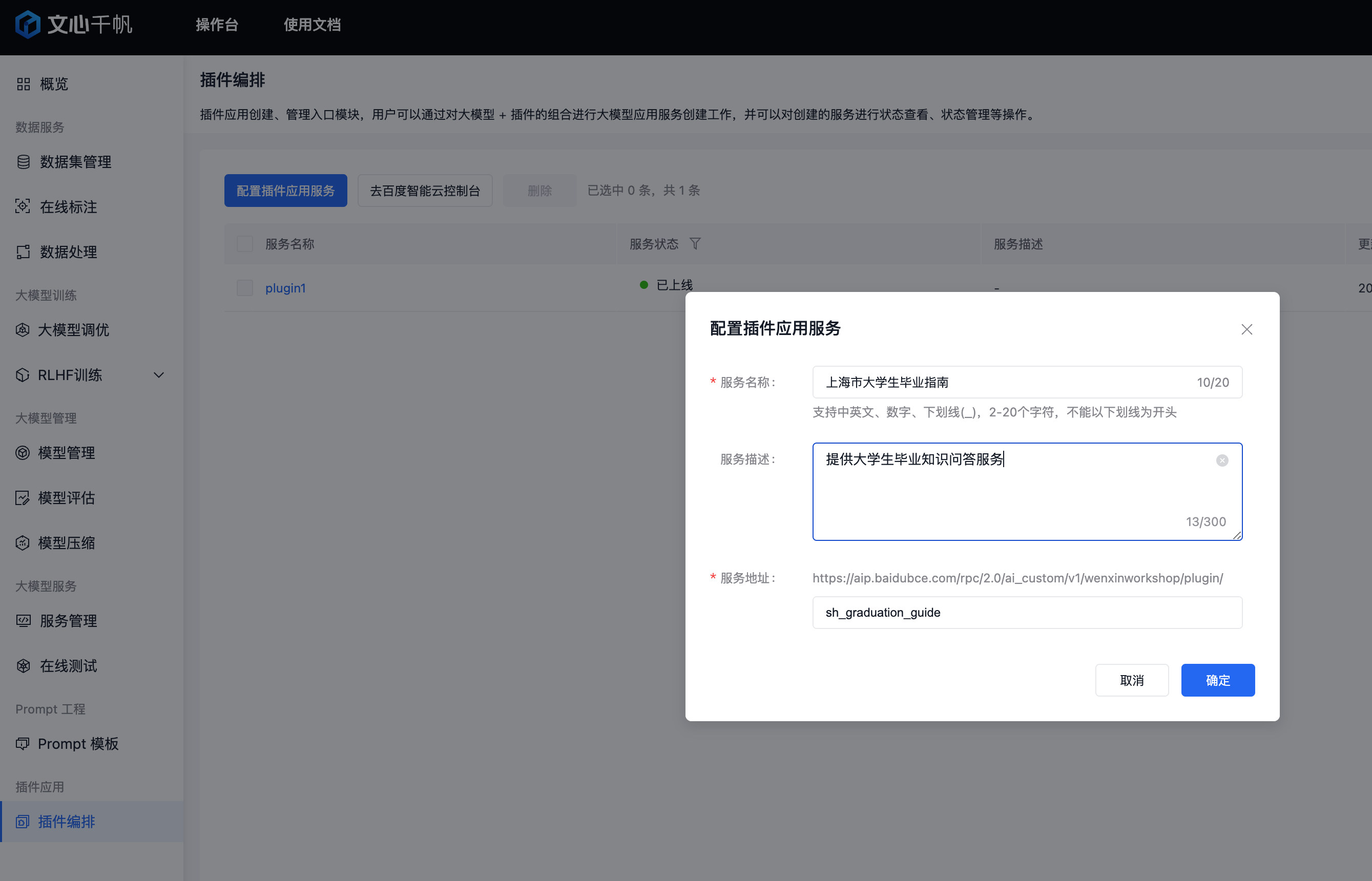

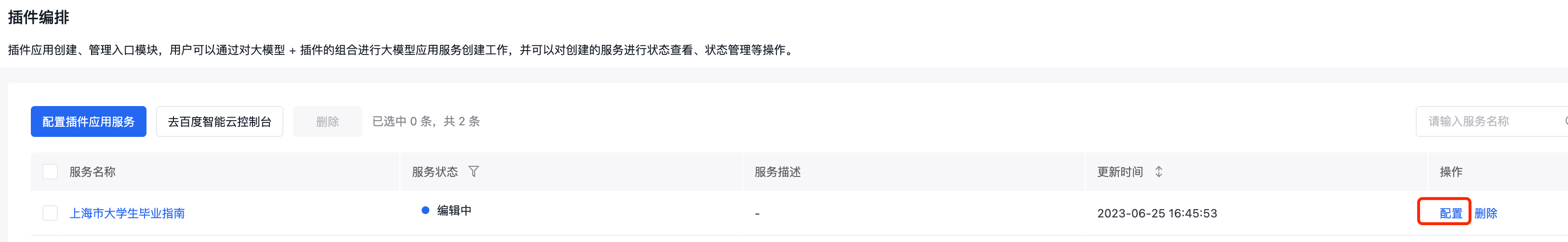

6.2域内知识搜索

-

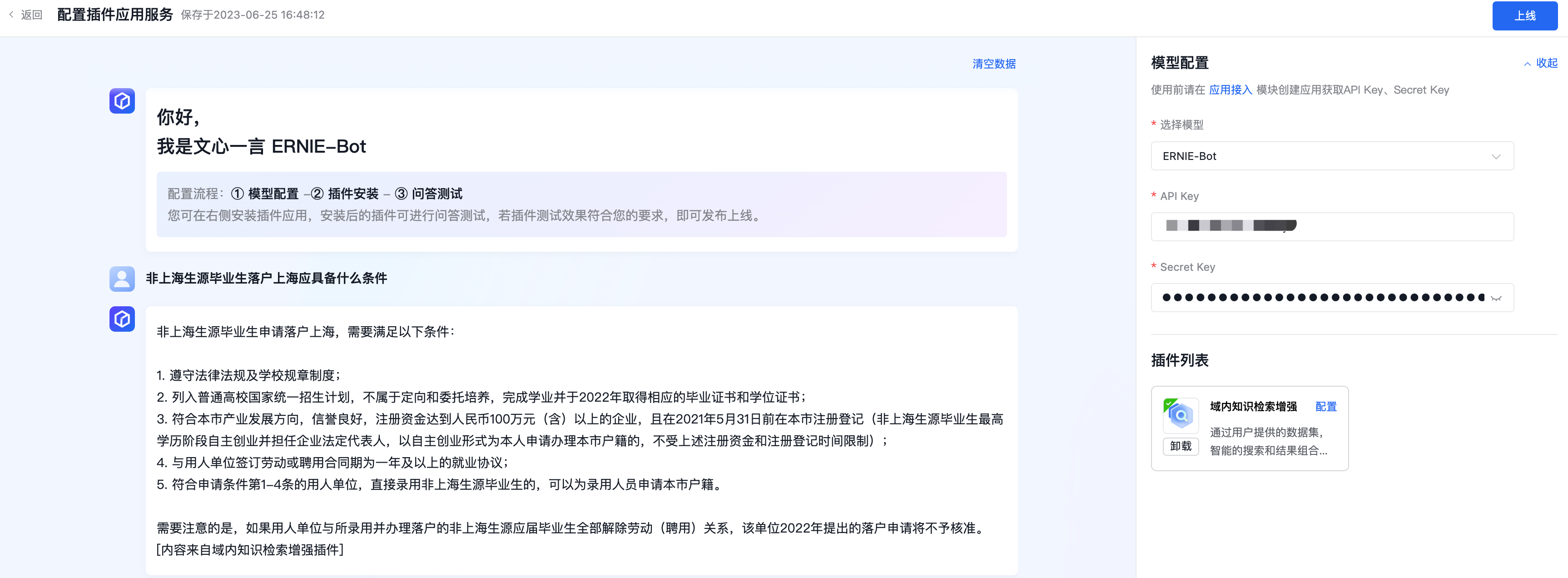

创建plugin插件,点击【配置插件应用服务】

-

配置插件

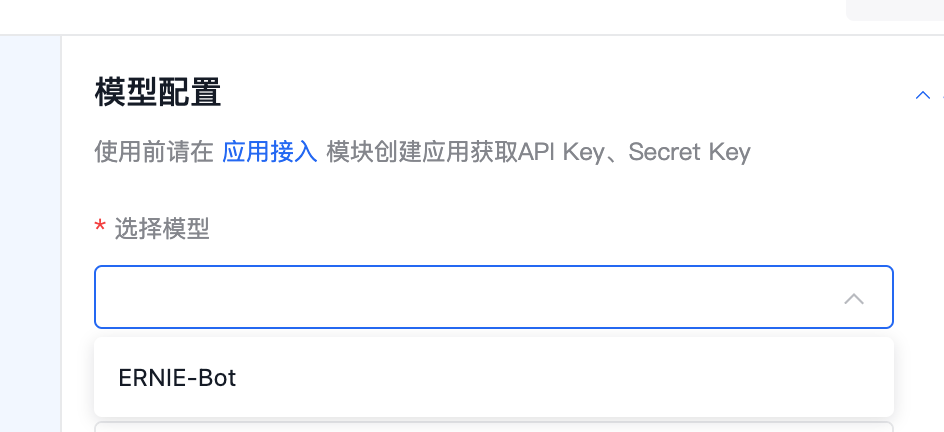

-

选择模型

-

配置模型调用ak/sk,这个在前面大模型服务管理章节已经讲过。

-

安装插件

-

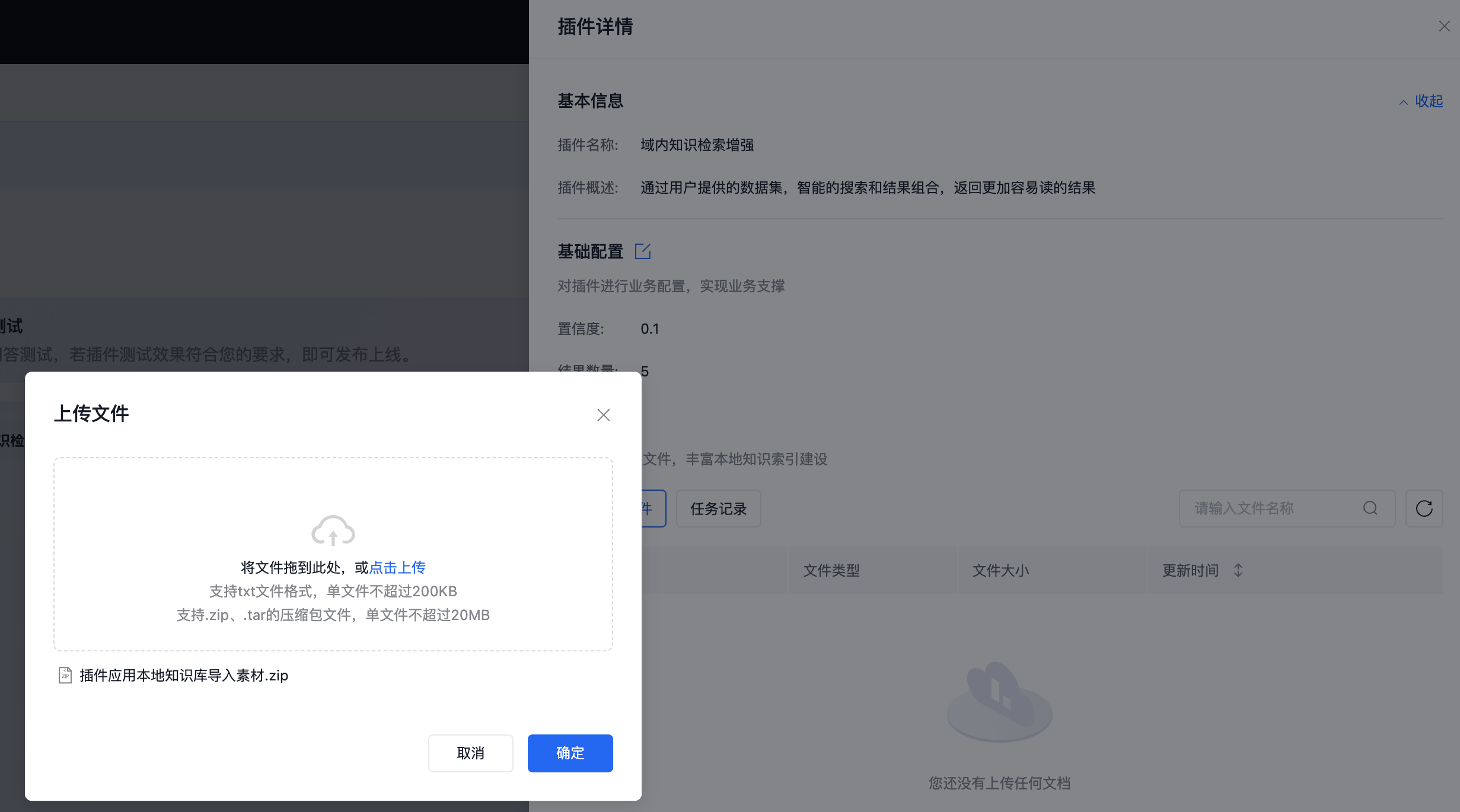

配置插件,上传本地知识文档。

-

查看上传文件内容

8.提问

非上海生源毕业生落户上海应具备什么条件

-

可以看到返回的内容是基于上传的知识库进行回答的,并且带有[内容来自域内知识检索增强插件]标记。

-

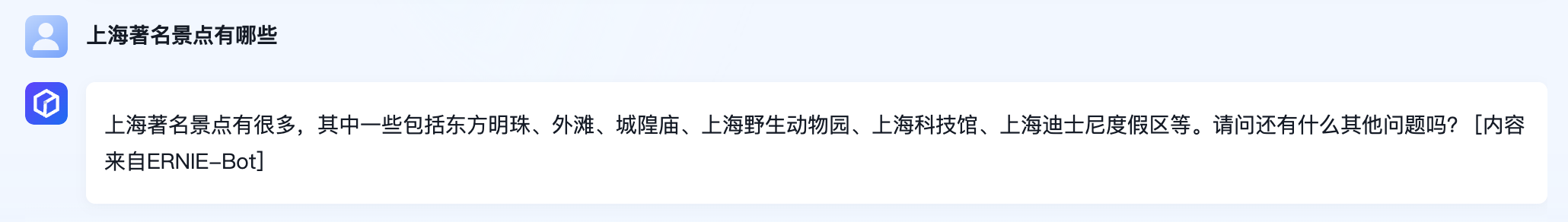

如果提问跟本地知识库无关的知识,会通过ERNIE-Bot直接返回, 返回答案带有[内容来自ERNIE-Bot]标记

上海著名景点有哪些

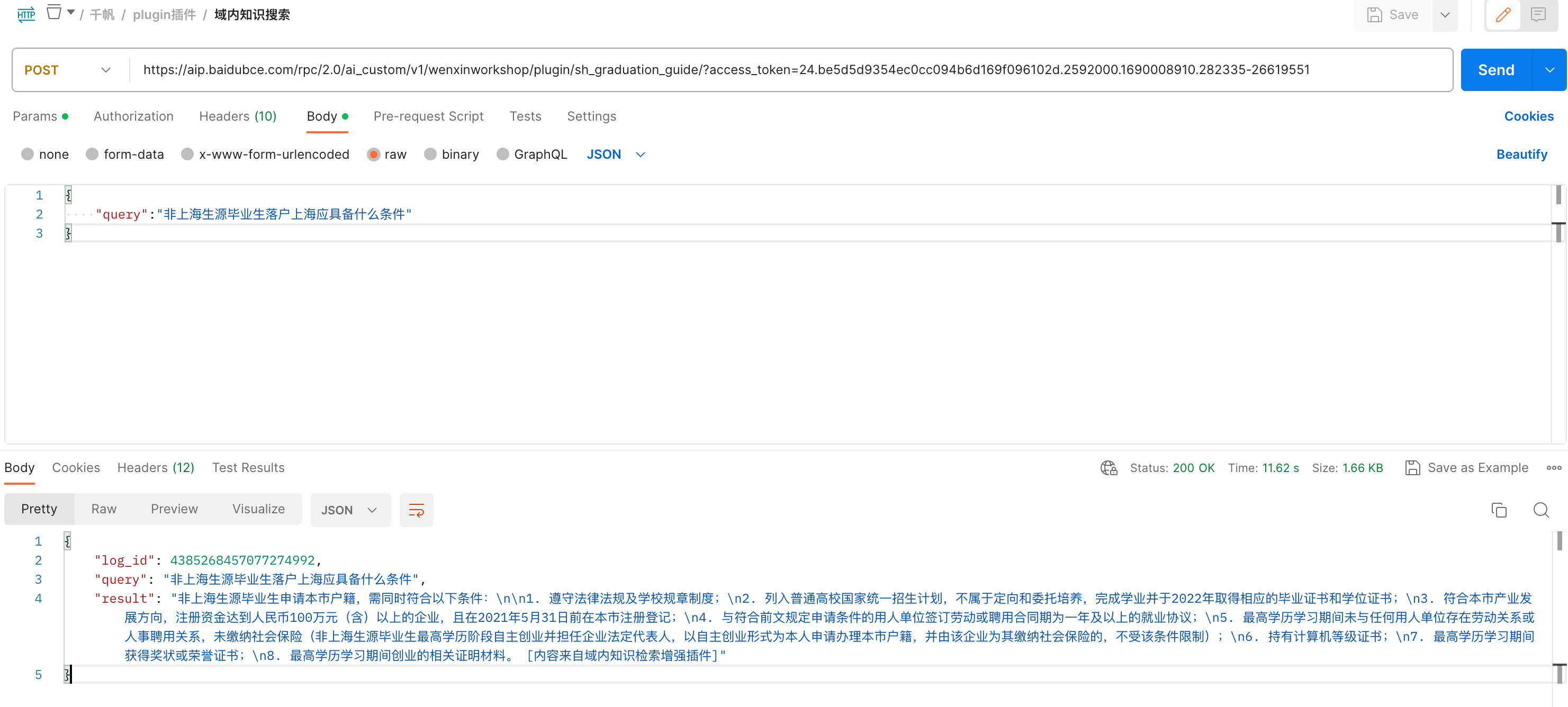

6.3postman接口调用

-

给应用授予插件应用的权限,在控制台勾选

-

接口调用

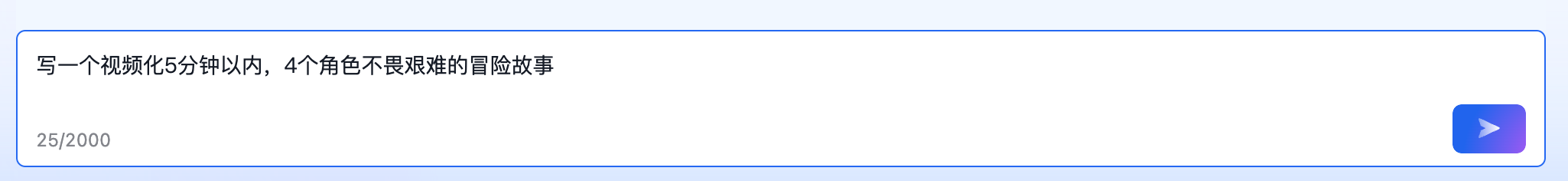

七、prompt工程

-

创建prompt模板

写一个视频化{number_1}分钟以内,{number_2}个角色{adjective}的{theme}故事。

-

在大模型服务当中,引用模板

-

按照模板填写关键字段

-

生成prompt

写一个视频化5分钟以内,4个角色不畏艰难的冒险故事。

-

发送请求

八、RLHF训练

注意:强化学习需要大量精标反馈数据,对于数据的要求非常高。普通的测试用例无法训练出来一个好的RLHF模型。

精标数据也是百度与客户共建大模型的一个背景。百度提供技术赋能。客户提供对应精标数据。

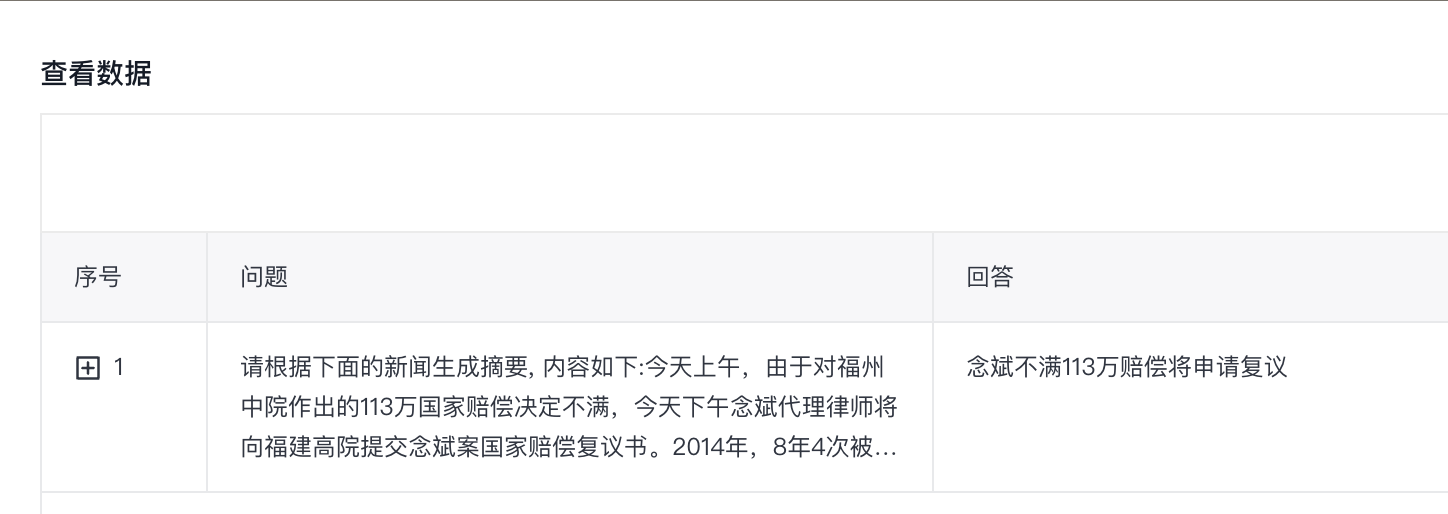

8.1数据集对应关系说明

前面大模型调优,用到的都是对轮对话-非排序列数据集。现在要进行强化学习训练,需要用到2类不同的数据集。

-

奖励模型训练:多轮对话-排序类

-

强化学习训练:query问题集

|

序号

|

训练任务分类

|

功能菜单

|

数据集类型

|

备注

|

示例

|

|

1

|

有监督微调

SFT

|

大模型调优

|

多轮对话-非排序类

|

1个对话包含多个prompt,每个prompt有1个response。

|

|

|

2

|

强化学习

RLHF

|

奖励模型训练

|

多轮对话-排序类

|

1个对话包含多个prompt。

1个prompt有多个response,比如response1、response2

|

|

|

3

|

强化学习训练

|

query问题集

|

只有prompt问题,没有response答案

|

|

8.2数据集导入

8.2.1奖励模型-多轮对话排序类

导入奖励模型训练所需的多轮对话排序类型数据集

8.2.2强化学习模型-prompt语料无标注

导入强化学习训练所需的prompt语料无标注数据集

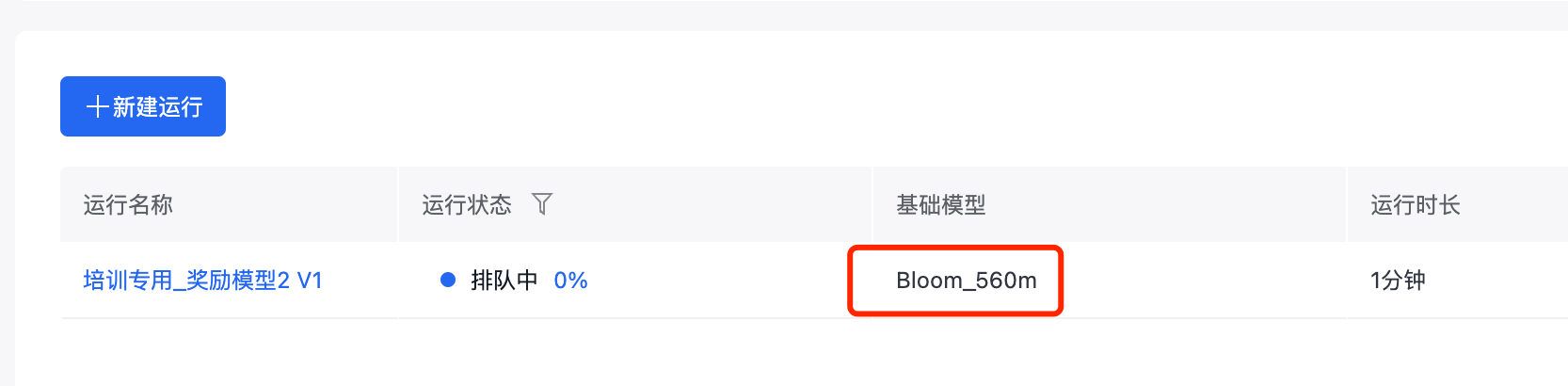

8.3奖励模型训练

-

创建训练任务

-

选择数据集,在奖励模型训练当中,只能选择到多轮对话-排序类数据集。

-

奖励模型是用一个内置的bloom5.6亿参数的模型进行训练的。

注意:预置服务那边预置的是bloom7B模型(70亿参数)

-

因为bloom_560m参数较小,奖励模型训练时长一般比较短。差不过1小时以内可以完成。

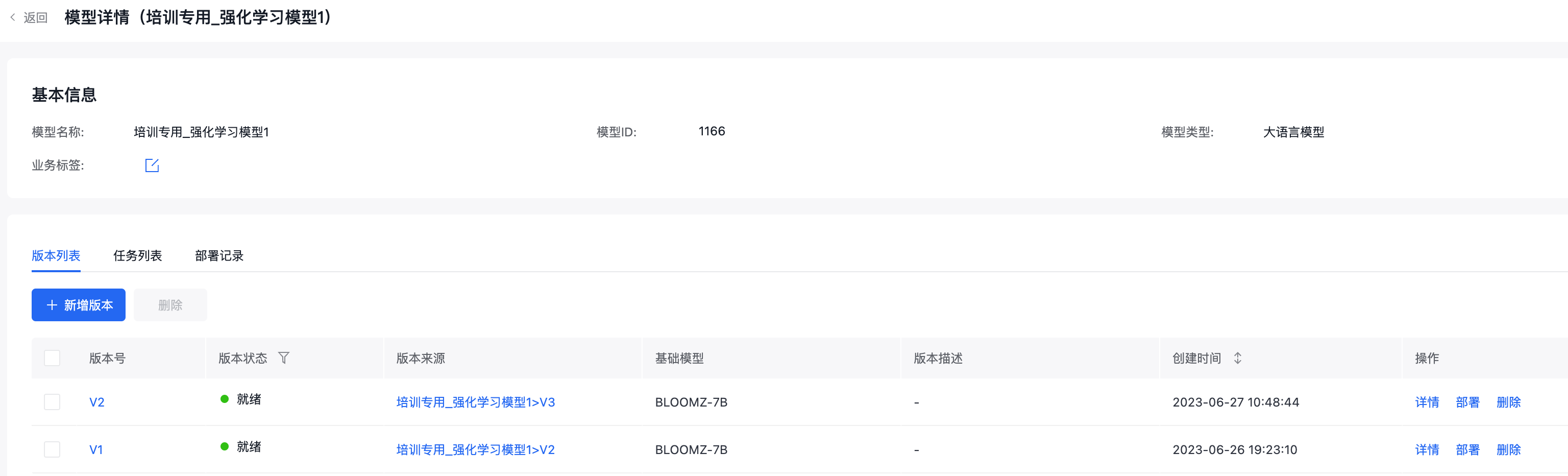

8.4强化学习训练

-

创建强化学习任务

-

强化学习训练需要用到前面提到的query问题集。

-

选择大模型:这里可以使用用户大模型,可以使用预置大模型。

注意:如果选择是用户大模型,这里下来列表对应的是【大模型调优】当中的训练任务列表当中的某个模型的某个版本。即关联的是训练任务,而非已发布的模型。

-

参数配置使用默认即可。

-

强化学习 1个epoch大概需要2个小时左右完成

-

点击发布,将模型发布至模型管理

-

点击部署,将模型部署至私有资源池

说明:

-

强化学习模型不支持评估、压缩。

-

强化学习模型的在线测试与api接口调用方式,与SFT模型一致。

评论