百度千帆大模型精调课程学习心得

AI原生应用开发/技术交流

- AI加速器线上加速营

2024.07.19709看过

本文是参与百度线上营,关于大模型精调课程后的学习心得。课程链接:https://dwz.cn/JARQ8eEc

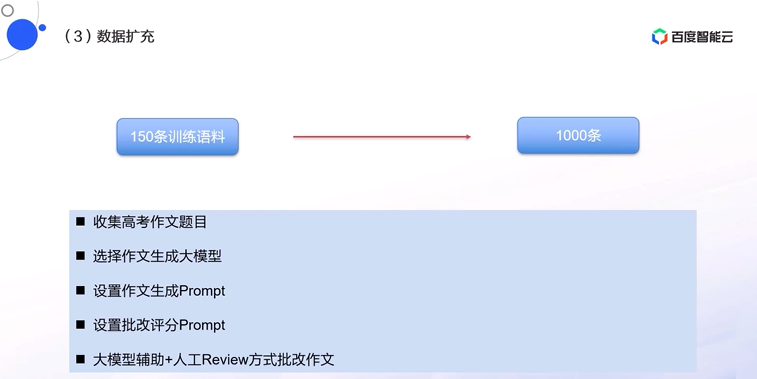

从2022年底,ChaGPT爆火以来,大模型技术及产业落地经历着飞速发展,到今日已近两年的时间。两年的时间里,知识以周为单位疯狂的刷新,业内人士经常表达“学不过来”,更何况在AI-NLP领域之外的“外行人”。大家听到了太多的名词,英文缩写,也看了太多的直播,听各种“大师”,“专家”预测未来发展趋势,介绍技术要点,分享落地经验。我经常会问一些朋友,听完这些分享,收获了什么。答案各不相同,其中一个很重要的原因是这些分享课程的质量很参差。东半球最懂AI的某博士,是最好不过的例子。那大模型到底该怎么学习,才能有收获呢?我们可以从大模型的本质谈起。大模型要解决的本质问题之一,就是让人类更自然的和世界交互。因此,天然的任务就是降低使用门槛。纸上得来终觉浅,躬行之,方得之的道理大家都懂,可碍于门槛,经常无法上手。但是大模型在不断降低这个门槛,所以更好的学习方式就是去使用,亲身体验。从市场投教的角度,大厂的投入客观可见。目前百度的文档详细程度,尤其视频教程的数量和更新速度,确实更好。只通过大模型对话窗口去体验基本能力,去体验提示词的调整已经不能满足很多学习者了,更深入的模型调整,知识挂载,是大家的共性需求。课程视频有科普理论,也有细节方法和操作教程。其中,第二章“作文自动点评或批改”,第3节“数据准备”另外印象深刻,数据的质量比数量重要,但是高质量的数据不容易获取,尤其面对数据缺失的问题时。今天大模型的生成能力,给出了一个更智能化解决数据缺失问题的方法,即基于多个大模型进行数据扩充。扩充时,要注意真实性的拟合,数据类型的全面覆盖,各个类别的合理比例,采用不同模型生成数据来防止风格单一,最后人工review保证质量。这样比过往单纯依赖真实数据,或者依赖人工扩充数据,大大提高效率。这一波LLM,除了在各个场景本身的应用,对于模型本身的制造过程,也要思考在哪些环节可以充分利用这一波的增量智能,提升模型制造效率。

综上,非常推荐大家开通账号,亲自尝试体验,掌握更多能力,发掘更多场景。

从2022年底,ChaGPT爆火以来,大模型技术及产业落地经历着飞速发展,到今日已近两年的时间。两年的时间里,知识以周为单位疯狂的刷新,业内人士经常表达“学不过来”,更何况在AI-NLP领域之外的“外行人”。大家听到了太多的名词,英文缩写,也看了太多的直播,听各种“大师”,“专家”预测未来发展趋势,介绍技术要点,分享落地经验。我经常会问一些朋友,听完这些分享,收获了什么。答案各不相同,其中一个很重要的原因是这些分享课程的质量很参差。东半球最懂AI的某博士,是最好不过的例子。那大模型到底该怎么学习,才能有收获呢?我们可以从大模型的本质谈起。大模型要解决的本质问题之一,就是让人类更自然的和世界交互。因此,天然的任务就是降低使用门槛。纸上得来终觉浅,躬行之,方得之的道理大家都懂,可碍于门槛,经常无法上手。但是大模型在不断降低这个门槛,所以更好的学习方式就是去使用,亲身体验。从市场投教的角度,大厂的投入客观可见。目前百度的文档详细程度,尤其视频教程的数量和更新速度,确实更好。只通过大模型对话窗口去体验基本能力,去体验提示词的调整已经不能满足很多学习者了,更深入的模型调整,知识挂载,是大家的共性需求。课程视频有科普理论,也有细节方法和操作教程。其中,第二章“作文自动点评或批改”,第3节“数据准备”另外印象深刻,数据的质量比数量重要,但是高质量的数据不容易获取,尤其面对数据缺失的问题时。今天大模型的生成能力,给出了一个更智能化解决数据缺失问题的方法,即基于多个大模型进行数据扩充。扩充时,要注意真实性的拟合,数据类型的全面覆盖,各个类别的合理比例,采用不同模型生成数据来防止风格单一,最后人工review保证质量。这样比过往单纯依赖真实数据,或者依赖人工扩充数据,大大提高效率。这一波LLM,除了在各个场景本身的应用,对于模型本身的制造过程,也要思考在哪些环节可以充分利用这一波的增量智能,提升模型制造效率。

综上,非常推荐大家开通账号,亲自尝试体验,掌握更多能力,发掘更多场景。

评论

![preview]()

发表评论

发布话题

发布话题